在当今的企业环境中,尤其是在保险和客户支持领域,语音和音频数据不仅仅是录音,它们是能够转变运营和客户体验的宝贵接触点。借助人工智能音频处理技术,企业可以以惊人的准确性实现自动转录,从对话中挖掘关键洞察,并实现自然且引人入胜的语音交互。通过利用这些功能,企业可以提高效率,维护合规标准,并与客户建立更深入的联系,同时满足这些要求严格的行业的高期望。

Boson AI 推出了 Higgs Audio Understanding(音频理解)和 Higgs Audio Generation(音频生成),这两款强大的解决方案能够帮助您为广泛的音频应用开发定制化的人工智能代理。Higgs Audio Understanding 专注于倾听和语境理解,而 Higgs Audio Generation 则擅长表现力丰富的语音合成。目前,这两款解决方案都已针对英语进行了优化,并且正在逐步支持更多语言。它们能够实现与自然人类对话极为相似的人工智能交互,企业可以利用这些工具为现实世界的音频应用提供支持。

Higgs Audio Understanding:

超越文字的倾听

Higgs Audio Understanding 是 Boson AI 的先进音频理解解决方案。它超越了传统的语音转文字系统,能够捕捉语境、说话者特征、情感和意图。该模型将音频处理与大型语言模型(LLM)深度整合,将音频输入转化为丰富的语境嵌入,包括语音语调、背景声音和说话者身份。通过结合文本标记进行处理,该模型能够实现细微的解释,这对于会议转录、呼叫中心分析和媒体存档等任务至关重要。

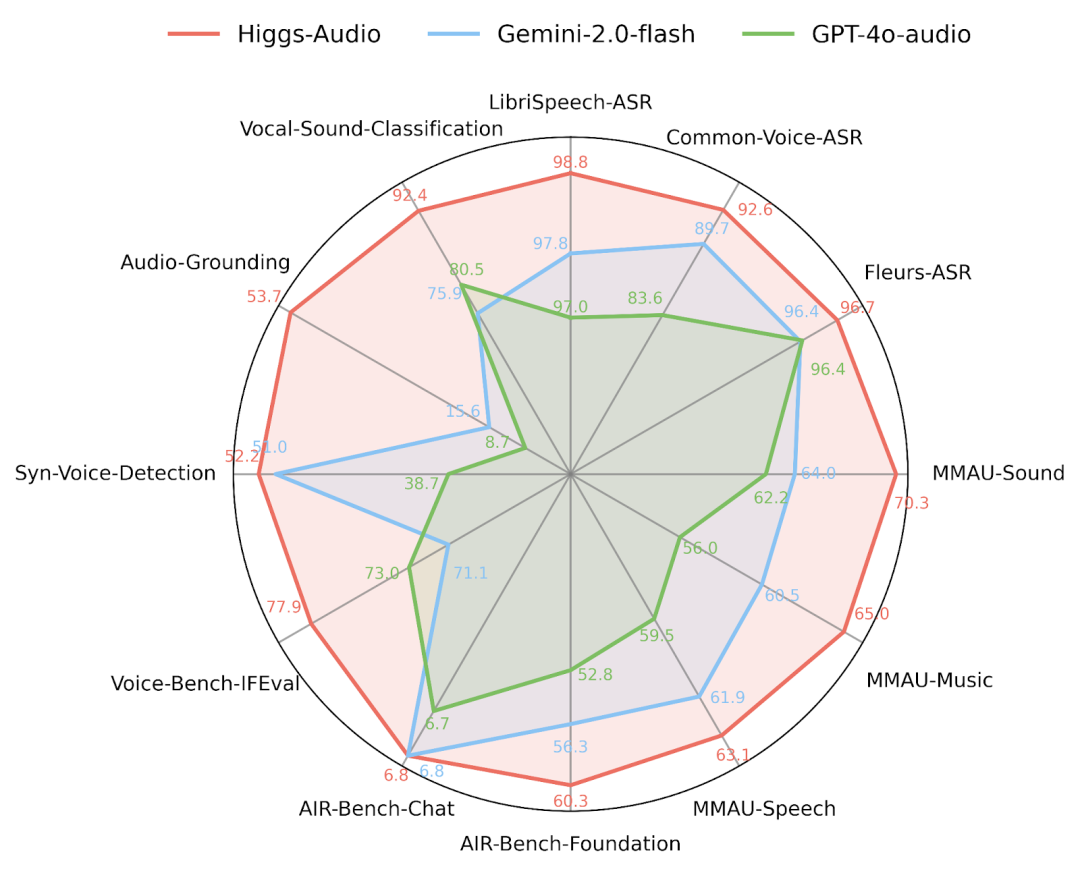

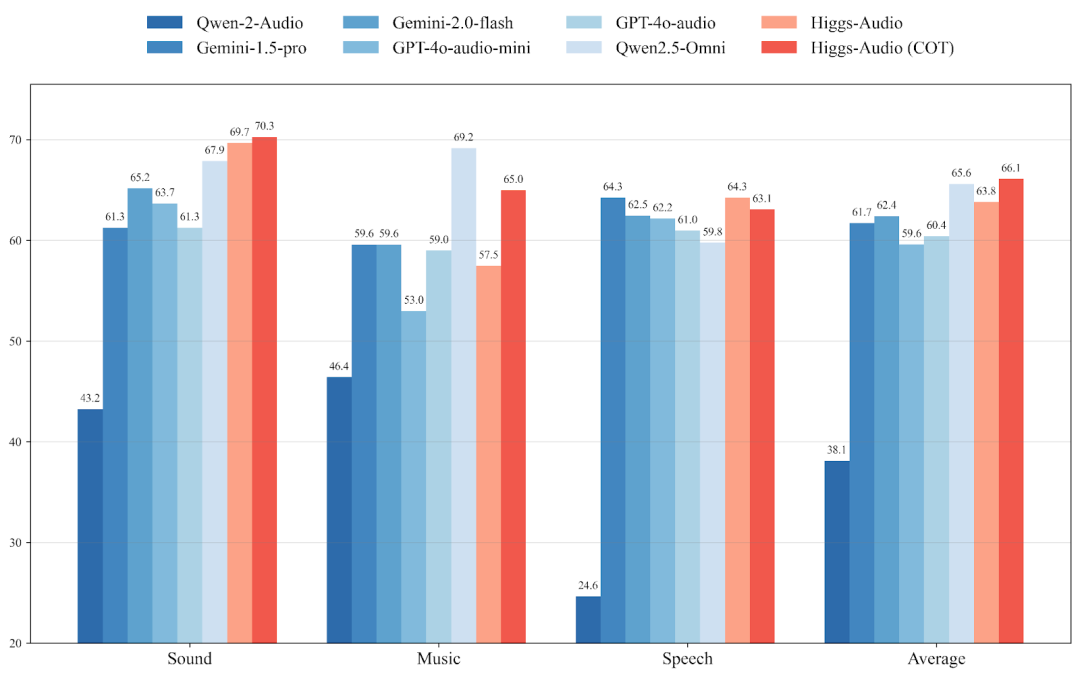

其关键优势在于其“链式思维”音频推理能力。这使得该模型能够以结构化、逐步的方式分析音频,解决复杂的任务,例如统计单词出现次数、从语调中解读幽默,或者将外部知识应用于音频语境。测试表明,Higgs Audio Understanding 在标准语音识别基准测试(例如英语的 Common Voice)中领先,并在全面的音频推理评估中超越了 Qwen-Audio、Gemini 和 GPT-4o-audio 等竞争对手,在 AirBench 基础测试中以 60.3 的平均分(凭借其推理增强功能)获得最高分。这种实时的语境理解能力可以为企业提供无与伦比的音频数据洞察。

Higgs Audio Generation:

具有人类细腻情感的语音合成

Higgs Audio Generation 是 Boson AI 的先进语音合成模型,能够为虚拟助手、自动化服务和客户互动提供极具表现力且类似人类的语音,这对于这些场景至关重要。与传统听起来像机器人的文本到语音(TTS)系统不同,Higgs Audio Generation 以大型语言模型为核心,能够根据文本语境和预期情感进行细腻的理解和富有表现力的输出。

Boson AI 解决了传统 TTS 的常见局限性,例如单调的语调、情感平淡、对不熟悉术语的错误发音以及处理多说话者互动的困难,通过将深度语境理解融入语音生成中。

Higgs Audio Generation 的独特功能包括:

-

情感细腻的语音:根据文本语境自然调整语调和情感,创造更具吸引力且符合语境的互动。

-

多说话者对话生成:该技术能够同时为多角色对话生成独特且逼真的声音,正如 Boson AI 的“魔法扫帚店”演示所展示的那样。它非常适合有声读物、互动培训和动态故事讲述。

-

准确的发音和口音适应:精准地发音不常见的名字、外语单词和技术术语,并根据全球和多样化的场景动态调整语音。

-

实时生成与语境推理:该技术能够产生连贯的实时语音输出,响应对话的变化,适合互动应用,例如客户支持聊天机器人或实时语音助手。

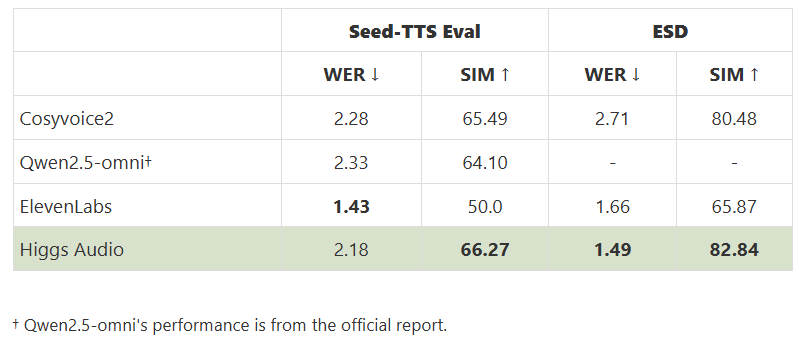

在标准测试(如 SeedTTS 和情感语音数据集(ESD))中,Higgs Audio 的情感准确性显著更高,同时在词错误率(约 1.5%–2%)方面具有竞争力或优于竞争对手。这些性能表现证明了 Higgs Audio 在清晰度、表现力和逼真度方面的卓越能力,为音频生成树立了新的基准。

技术内幕

大型语言模型、音频标记器和上下文学习

Boson AI 的 Higgs Audio 模型利用先进的研究,将大型语言模型与创新的音频处理技术相结合。在核心部分,这些模型利用预训练的大型语言模型,将其强大的语言理解、语境感知和推理能力扩展到音频任务。Boson AI 通过在大量的配对文本–音频数据集上端到端地训练大型语言模型,实现了这种整合,使模型能够语义理解口语内容和细微的音频细节。

Boson AI 的定制音频标记器是一个关键元素,它使用残差向量量化(RVQ)高效地将原始音频压缩成离散的标记。这保留了语言信息和微妙的音频细节(语调、音色),同时平衡标记的粒度以实现最佳的速度和质量。这些音频标记与文本一起无缝地输入到大型语言模型中,使模型能够同时处理音频和文本语境。此外,Higgs Audio 还融入了上下文学习,使模型能够快速适应而无需重新训练。通过简单的提示,例如简短的参考音频样本,Higgs Audio Generation 可以即时进行零样本语音克隆,匹配说话风格。同样,Higgs Audio Understanding 可以通过最少的提示快速定制输出(例如,说话者标记或特定领域的术语)。

Boson AI 的方法整合了基于 Transformer 的架构、多模态学习和链式思维(CoT)推理,增强了音频理解和生成任务的可解释性和准确性。通过将大型语言模型的优势与复杂的音频标记和灵活的提示相结合,Higgs Audio 提供了无与伦比的性能、速度和适应性,显著超越了传统的音频人工智能解决方案。

基准性能

超越行业领导者

Boson AI 对 Higgs Audio 进行了广泛的基准测试,确认了其在音频理解和生成方面相对于顶级行业模型的竞争力。

在音频理解方面,Higgs Audio 与 OpenAI 的 GPT-4o-audio 和 Gemini-2.0 Flash 等模型相匹配或超越。它提供了顶级的语音识别准确性,在 Mozilla Common Voice(英语)测试中取得了最先进的结果,在具有挑战性的任务(如中文语音识别)上表现出色,并在 LibriSpeech 和 FLEURS 等基准测试中取得了强劲的成绩。

然而,Higgs Audio Understanding 真正与众不同的地方在于复杂的音频推理任务。在 AirBench 基础测试和 MMAU 基准测试等全面测试中,Higgs 超越了阿里巴巴的 Qwen-Audio、GPT-4o-audio 和 Gemini 模型,平均得分为 59.45,启用链式思维推理后得分超过 60。这表明该模型具备卓越的能力,能够理解复杂的音频场景和对话,即使在有背景噪音的情况下,也能逻辑清晰且富有洞察力地解读音频语境。

在音频生成方面,Higgs Audio 与专门的 TTS 模型(包括 ElevenLabs、Qwen 2.5-Omni 和 CosyVoice2)进行了对比。Higgs Audio 在关键基准测试中始终领先或与竞争对手不相上下:

-

Seed-TTS 评估:Higgs Audio 实现了最低的词错误率(WER),表明其语音高度可理解,并且与参考语音的相似度最高。相比之下,ElevenLabs 的可理解性略低,但语音相似度明显更弱。

-

情感语音数据集(ESD):Higgs Audio 实现了最高的情感相似度得分(超过 80,而 ElevenLabs 仅为中等 60 多分),在情感细腻的语音生成方面表现出色。

Boson AI 还引入了“EmergentTTS-Eval”,使用先进的音频理解模型(即使是竞争对手的 Gemini 2.0)作为评估者。在涉及情感表达、发音准确性和细腻语调的复杂场景中,Higgs Audio 一直比 ElevenLabs 更受青睐。总体而言,基准测试清楚地显示了 Higgs Audio 的全面优势,确保采用 Boson AI 模型的用户能够获得卓越的音质和深入的理解能力。

企业部署和用例

将 Higgs Audio 带入商业领域

Higgs Audio Understanding 和 Higgs Audio Generation 在一个统一的平台上运行,能够实现实时的端到端语音人工智能管道,能够倾听、推理并做出回应。

No.1

客户支持:

在像 Chubb 这样的公司中,由 Higgs Audio 提供支持的虚拟理赔代理能够以高精度转录客户电话,检测压力或紧迫性,并识别关键的理赔细节。它可以自动分离说话者并解读语境(例如,识别车祸场景)。Higgs Audio Generation 以富有同情心且自然的声音做出回应,甚至可以适应来电者的口音。这提高了问题解决速度,减轻了员工的工作负担,并提升了客户满意度。

No.2

媒体和培训内容:

生产电子学习或培训材料的企业可以使用 Higgs Audio Generation 创建多声音、多语言的旁白,而无需聘请配音演员。Higgs Audio Understanding 通过验证脚本的遵循情况和情感语调来确保质量控制。团队还可以转录和分析会议,以获取说话者的情感和关键要点,从而简化内部知识管理。

No.3

合规与分析:

在受监管的行业,Higgs Audio Understanding 可以通过识别意图(而不仅仅是关键词)来监控对话以确保合规。它可以检测与批准脚本的偏差,标记敏感披露内容,并从数千通电话中挖掘客户趋势或痛点,从而提供主动的洞察并确保符合法规。

Boson AI 提供灵活的部署方式,包括 API、云服务、本地部署或授权许可,模型可以通过基于提示的定制化进行调整。企业可以利用上下文学习将输出定制为特定领域的术语或工作流程,构建能够匹配内部词汇和语调的智能语音代理。从多语言聊天机器人到自动会议总结,Higgs Audio 提供真正类似人类的对话人工智能,提升了企业语音应用的质量和能力。

未来展望和战略要点

Boson AI 为 Higgs Audio 规划的路线图显示了未来将深化音频理解和生成功能的强大功能管道。一个关键的即将推出的功能是多声音克隆,允许模型从简短的样本中学习多个声音配置文件,并在说话者之间生成自然的对话。这将启用如人工智能驱动的配音录制或在客户接触点上保持一致的虚拟声音等用例。这超越了目前的单说话者克隆,Boson AI 的 TTS 演示已经暗示了它的到来。另一项发展是明确控制风格和情感。虽然当前模型从语境中推断情感,但未来的版本可能会允许用户指定“愉快”或“正式”等参数,增强品牌一致性和用户体验。Boson AI 演示中预览的智能语音功能表明,将有一个根据脚本语调和意图量身定制的智能语音选择系统。

在理解方面,未来的更新可能会通过长篇对话总结、通过扩展的链式思维能力进行更深入的推理以及实时流媒体支持等功能来增强理解能力。这些进步可能会启用如支持电话的实时分析或人工智能驱动的会议洞察等应用。

从战略上讲,Boson AI 将 Higgs Audio 定位为统一的企业音频人工智能解决方案。通过采用 Higgs Audio,公司可以访问语音人工智能的前沿,使用能够以人类水平的细腻程度理解、推理和说话的工具。其在理解和生成方面的双重优势,建立在共享的基础设施上,允许无缝集成和持续改进。企业可以从一个一致的平台上受益,模型共同进化,易于适应并保持领先。Boson AI 为企业创新提供了一个面向未来的基石,在一个越来越由音频界面塑造的世界中。

(文:AI音频时代)