跳至内容

MLNLP社区是国内外知名的机器学习与自然语言处理社区,受众覆盖国内外NLP硕博生、高校老师以及企业研究人员。

社区的愿景是促进国内外自然语言处理,机器学习学术界、产业界和广大爱好者之间的交流和进步,特别是初学者同学们的进步。

数学能力的重大突破:腾讯发布的DeepMath-103K是什么?

如果LLM要参加奥数竞赛,它需要刷多少题?传统题库可能只有“课后习题”水平,而DeepMath-103K直接准备了10.3万道高难度数学题

,涵盖从初中几何到大学微积分,甚至竞赛级题目(比如椭圆线积分、组合数学等)。

论文:DeepMath-103K: A Large-Scale, Challenging, Decontaminated, and Verifiable Mathematical Dataset for Advancing Reasoning

链接:https://github.com/zwhe99/DeepMath/blob/main/deepmath-103k-report.pdf

题目:计算椭圆上的线积分,但积分公式里有个“坑”——某点在椭圆内会导致公式失效。

这种题对人类都是挑战,而LLM通过这个题库训练后,能学会避开陷阱,找到解题关键。

为什么它比现有数据集更牛?

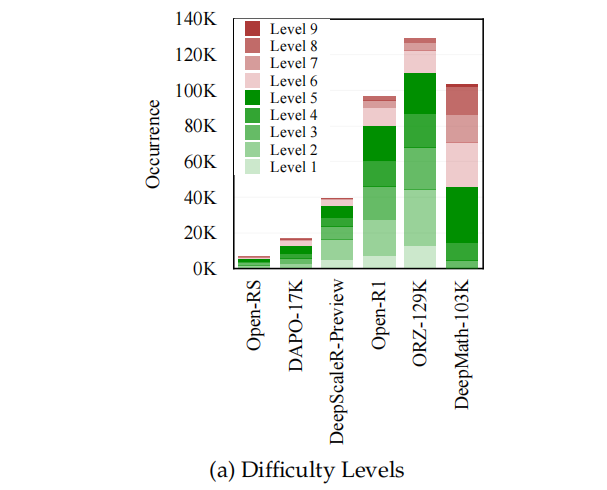

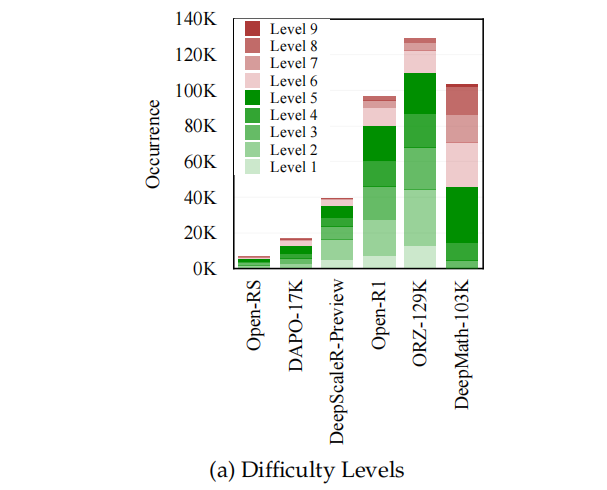

普通数学题库的题目难度像“爬小山”,而DeepMath-103K直接让LLM“登珠峰”。 论文数据显示,它的问题85%集中在难度5-9级(最高10级),远超其他公开数据集。

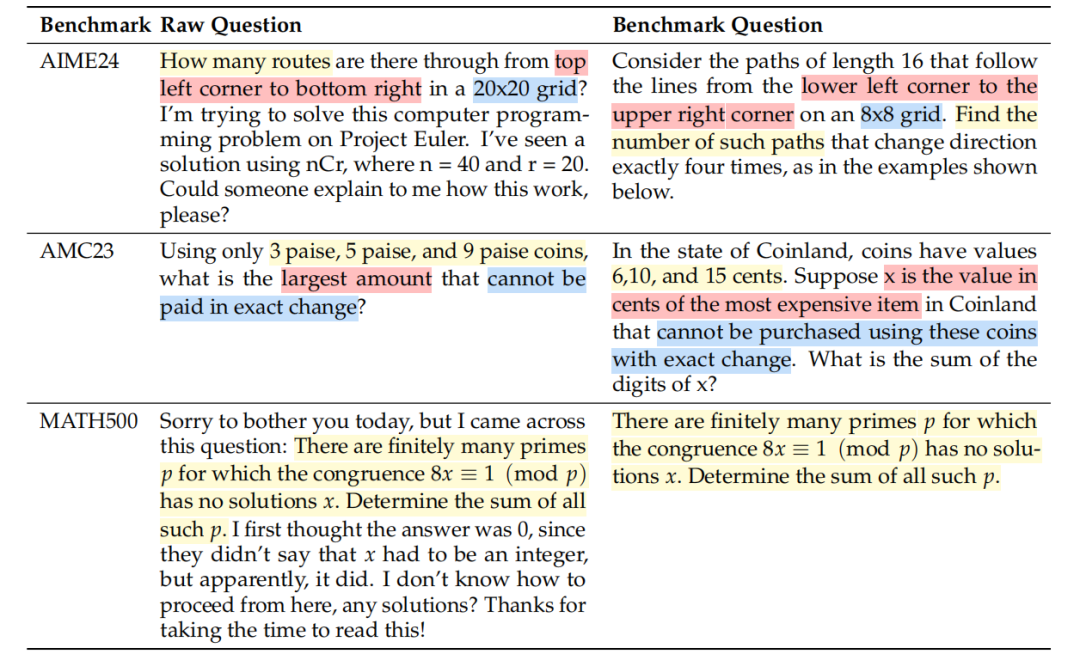

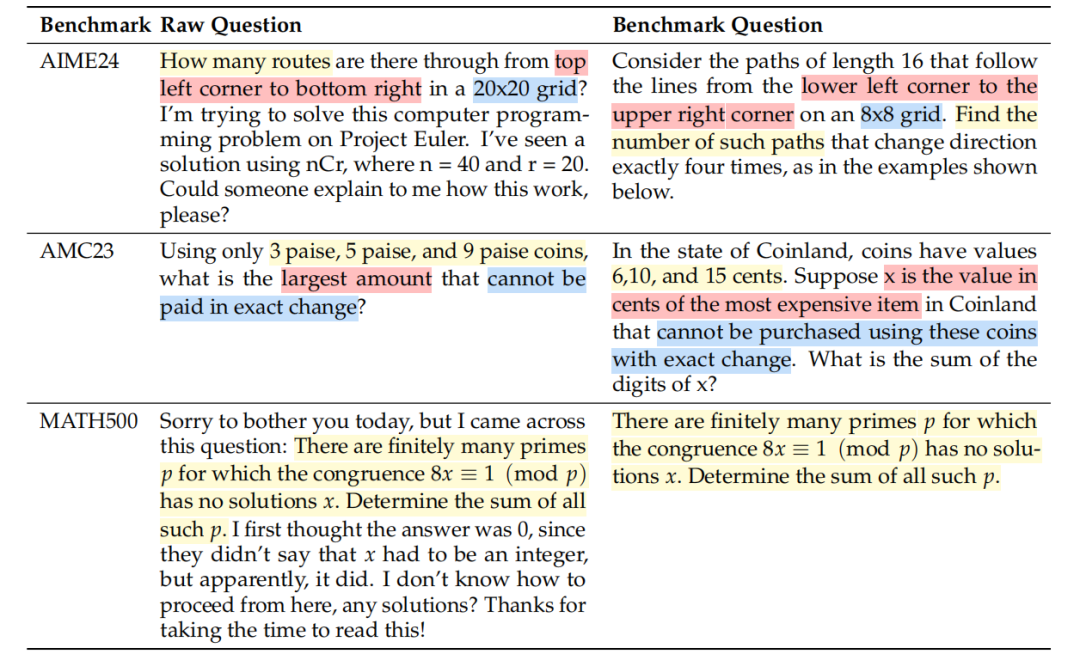

传统数据集常混入“考试真题”,导致AI刷题时提前“偷看答案”(比如AMC/AIME竞赛题)。而DeepMath-103K用侦探技术,通过语义对比和模型判断,删除了90%的相似题目,确保训练后的是“真学霸”,不是“背题机器”。

每个题都有唯一可验证的答案(比如数值或符号结果),AI每做一题,系统能秒速判对错。这让AI像学生刷题一样,快速纠正错误,迭代进步。

每个题目附带3种不同解法,比如用几何分析、代数变形或数值计算。模型学完后,能灵活切换思路,解决同类问题更游刃有余。

打造过程有多硬核?

团队从数学论坛、竞赛题库等渠道抓取286万道题,但90%因“太简单”或“重复”被淘汰。

用语义模型和Llama-3大模型对比题目,像老师查重论文一样,把疑似“考试原题”全部删除。例如,一个关于“硬币找零”的题和AMC真题高度相似,直接被踢出题库。

剩下的题目让GPT-4扮演“奥数教练”,从知识深度、步骤复杂度等维度打分,只保留5级以上的题。

生成3种解法,确保最终答案一致。比如某题若出现“2+3=6”这种低级错误,直接整题作废。

实战效果:用了它的LLM有多强?

训练后的模型(如DeepMath-Zero-7B)在多个数学竞赛级测试中表现逆天:

AMC23(美国数学竞赛):准确率64.7%,碾压其他模型

更神奇的是,解题步骤变得更长、更详细。比如在AIME24测试中,推理文本从1500字暴涨到12000字(话说…这是好事还是?)

对未来的意义:离数学家还有多远?

DeepMath-103K的诞生,让AI的数学推理能力迈出一大步。未来,这种“高难度题库+强化学习”的模式可能用于:

当然,模型目前还不会自主提出“黎曼猜想”,但至少,它离“奥数金牌”越来越近了。

(文:机器学习算法与自然语言处理)