AI 时代项目复刻的速度有多快?

周四0:00出的 Manus,

周五晚上10:57 MetaGPT 开始 OpenManus 的第一次提交,

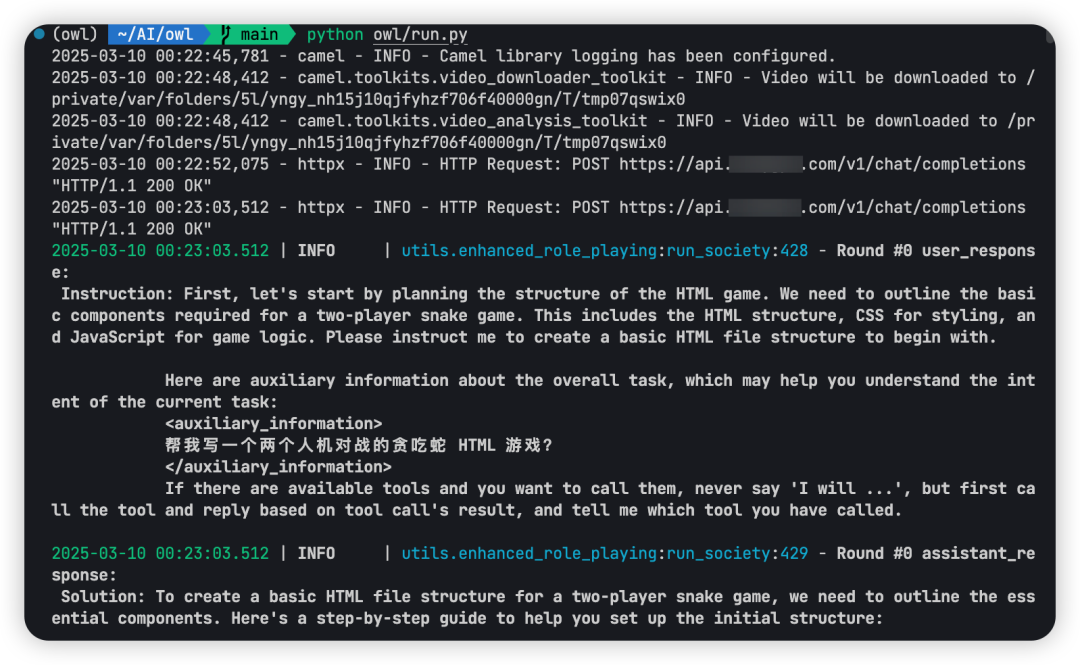

OWL 更夸张,CAMEL AI 在周四凌晨5:37从 Deep Swarm 改名为 OWL 后,开始提交更新。在 GAIA 基准测试,也就是 Manus 超过 OpenAI o1 Deep Research 的同款测试里,其 Level 1 分数达到 81.13,也超过了Deep Research,接近 Manus 的 86.5。

因为现在验证码还是一码难求,很多人还对这两个项目实际效果很感兴趣的,但是项目安装有门槛,尤其是 OWL,光是配 Key 就需要 OPENAI_API_KEY、GOOG_API_KEY、SEARCH_ENGINE_ID、HF_TOKEN、CHUNKR_API_KEY、FIRECRAWL_API_KEY,还需要基础的 python 环境和代码运行知识。

刚好上次我做了 Manus VS OpenAI o1 Deep Research & Claude3.7 Extended thinking,

Manus、OpenAI Deep Research 20个用例大横评,通用Agent抛弃奥特曼了。。。吗?

这次就算是硬刚 Manus 的第二篇,开源篇。

Here we go!

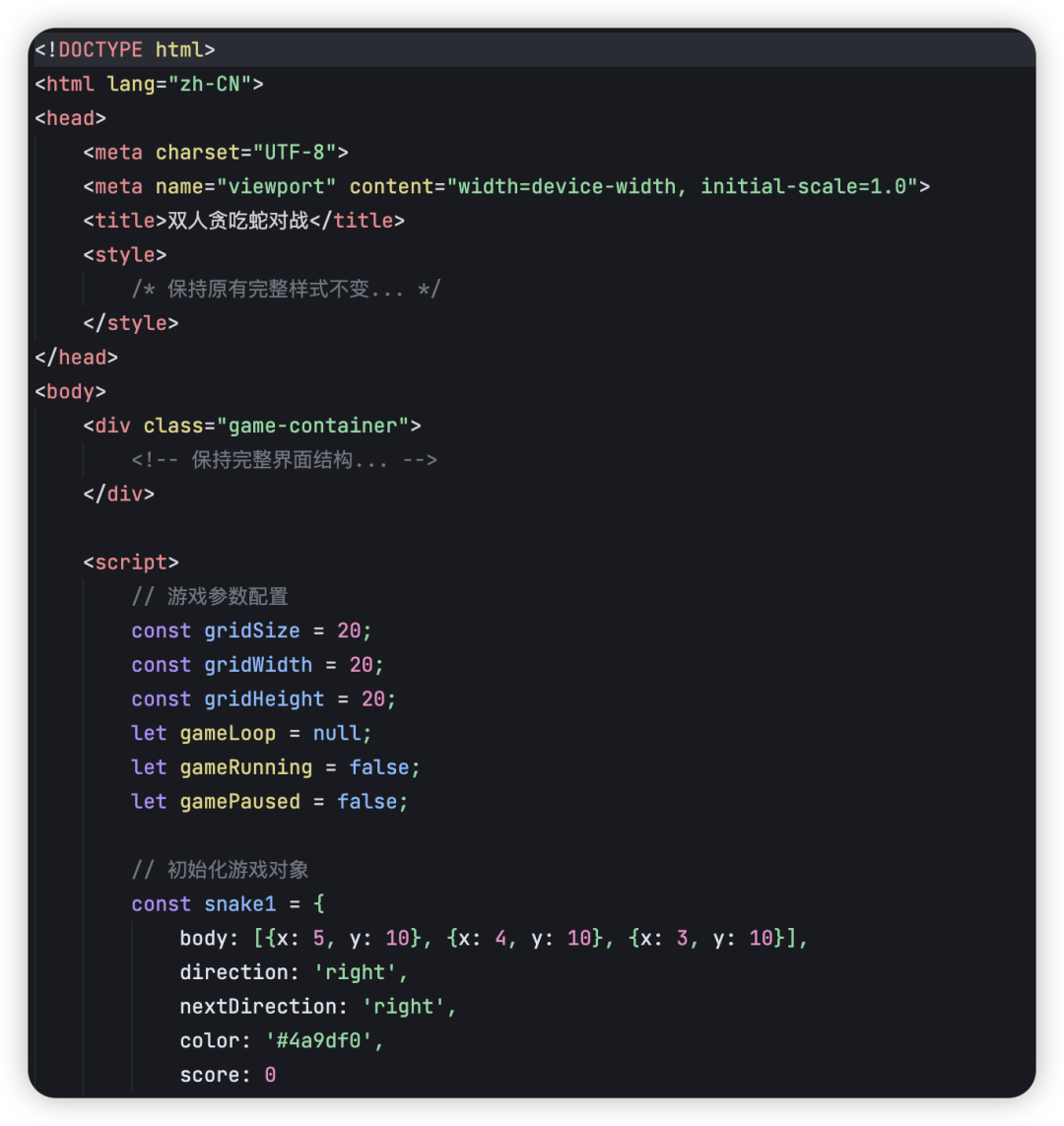

问题一、帮我写一个两个人机对战的贪吃蛇 HTML 游戏?

上来我们先来个难的,

之前测试 o1 Deep Research 的时候,这类游戏类就基本是它的死对头,就算人工将生成好的代码放到本地运行出错率也很高

再次赞一下 Manus 的完成率是真的很高,之前 Grok3 画的 ai game 的饼都快要实现了。

目前 OpenManus 和 QWL 都没有可视化界面,OpenManus主要是通过命令行输入提示语交互,而 QWL 是通过在代码文件里面修改问题文本完成交互,所以我会用 Trae 分别打开两个项目,尽可能把运行过程完整保留下来。

再再再严谨一点,这次的测试时间是03/10/12:00更新到两个项目的最新版本。

蓝色就是我控制的小蛇,OWL 的输出是分回合的 Round,但因为是命令行,一点点观看体验都没有,我用 Claude 总结出了 OWL 的思考步骤:

1. 基础搭建

- 创建 HTML 结构(canvas 元素)

- 设置 CSS 样式(居中显示)

- 初始化 JavaScript 变量和函数

2. 核心功能实现

- 蛇的移动控制(方向键和 WASD)

- 碰撞检测(边界、自身、对手)

- 食物系统(随机生成、得分)

3. 完善与测试

- 添加计分系统

- 实现游戏结束逻辑

- 进行功能测试和验证

为了保证输出的完整过程,运行的时候可以试试看python owl/run.py > q1.log 2>&1

OpenManus 是会自动写入同目录的logs的,虽然命令行输出还是比较难读,但是好处是给出了执行步骤、当前轮次使用的工具以及思考过程,并且还支持多轮对话。

2025-03-10 00:46:15.765 | INFO | app.agent.toolcall:think:54 - 🛠️ Manus selected 0 tools to use

2025-03-10 00:46:15.765 | INFO | app.agent.base:run:137 - Executing step 2/30

2025-03-10 00:46:26.661 | INFO | app.agent.toolcall:think:53 - ✨ Manus's thoughts: It looks like you've shared a conversation with an AI assistant called "OpenManus" that involved creating a two-player snake game in HTML. The conversation shows:

可惜前后2次都生成失败了。我同样让 Claude3.7 总结 OpenManus的思考和执行过程:

一、需求处理

1. 接收中文请求 → 解析双人控制/实时对战需求

2. 识别技术栈 → 选定HTML+CSS+JS组合

二、开发实施

- 对象建模:双蛇独立对象(坐标/颜色/控制)

- 核心逻辑:碰撞检测算法 + 游戏循环控制

- 界面构建:中文面板 + 状态按钮

三、输出响应

1. 生成完整可执行文件: /Users/lhj/AI/OpenManus/games/snake.html

2. 持续验证:30步循环校验控制逻辑与状态同步

3. 明确工具边界:声明专属工具集(PythonExecute/FileSaver)与通用编码能力

核心机制

- 稳定响应:相同请求始终保持代码一致性

- 语义理解:自动关联日志位置(如768行特征声明)

- 路径控制:严格限定输出路径为绝对路径

问题二、人物心理侧写

收集小米创始人 雷军 的公开发言信息以及互联网上对他的深入分析文章,分析他的世界观,人生观和价值观,穿透决策结果,找到他的决策第一模式。

输出一份关于他内心深处的心理侧写 PDF 报告。

Manus 总结出雷总的决策第一模式是”价值驱动型决策”,这种决策模式以价值观先行、长期主义思维和用户视角优先为核心特征。虽然Manus没有直接输出PDF,但是系统本身支持将txt导出成PDF。

这个问题就是绝对的烧 Token 大头,跑半回我的 API 额度就花完了,伤不起啊,半个回合就花了2.97刀,按照这样计算的话,Manus一个月$200的话都不能算贵。。。

我们看看OWL表现如何,还是通过 Claude3.7 总结:

从日志分析,owl完成任务的过程如下:

1. 信息收集阶段 :

- 使用搜索工具搜索了"Lei Jun public speeches"

- 获取到三个主要文章来源:

- Lei Jun在印度的英语演讲

- Lei Jun的年度演讲

- 小米造车进展的相关报道

2. 内容分析阶段 :

- 使用document_processing_toolkit提取并分析了这些文章的内容

- 整理了Lei Jun的世界观、人生观和价值观

- 总结了他的决策风格和领导方式

3. PDF生成尝试 :

- 尝试使用两个不同的Python库生成PDF:

- 首先尝试使用 fpdf 库

- 然后尝试使用 reportlab 库

- 但两次尝试都失败了,原因是环境中缺少这些库(ModuleNotFoundError)

只筛选出了3篇文章来源,这个应该是比目前的 Deep Research和 Deep Search系统们的参考网页数要少。优点是并没有产生幻觉,还是得到了雷总的侧写报告。

雷军心理侧写报告

一、世界观

1. 创新与技术作为变革催化剂

- 坚信技术能够改善生活

- 通过小米在智能手机、智能家居和物联网等领域的扩张体现创新承诺

2. 全球视野

- 致力于扩大小米的全球影响力

- 拥抱国际市场和多元化的消费者需求

二、人生哲学

1. 勇气与韧性

- 在面对美国制裁等挑战时展现出坚韧

- 自筹资金投资造车项目,展现冒险精神和长期目标追求

2. 以用户为中心

- 重视用户反馈和互动

- 通过小米社区建立强大的用户基础

三、价值观

1. 专注与卓越

- 鼓励团队在特定领域追求卓越

- 注重产品质量而非数量

2. 社会责任

- 积极支持公益事业

- 强调技术创新与社会发展的结合

四、决策风格与领导力

1. 决策特点

- 战略性和长期导向

- 基于用户反馈做出决策

- 注重可持续发展和创新

2. 领导方式

- 以人为本的管理风格

- 注重团队建设和人才发展

- 营造开放的企业文化

- 具有远见和感召力

五、核心特征

1. 务实真诚的个人风格

2. 强调勇气和突破

3. 重视长期战略目标

4. 亲力亲为的工作态度

5. 注重用户价值和社会影响

结论:

雷军展现出一个既有远见又脚踏实地的科技企业家形象。他的决策模式融合了战略思维、用户导向和社会责任感,形成了独特的领导风格。他的成功源于对技术创新的坚持、对用户需求的关注以及在面对挑战时展现出的勇气与决心。

我个人是更喜欢 OWL 的总结风格。接下来看看 OpenManus

这次没有输出。。。

这个真不是我刻意黑 OpenManus,运行了两次,它从一开始就卡在了工具调用。因为我还没有把源代码会过一遍(太肝了),但目前OpenManus除了配置 Claude API 就没有其他三方 API 工具(如联网等)的配置了,会不会后续把支持的工具列表放出来。

从日志分析来看,虽然最初的请求是要生成一个关于雷军的心理分析报告,但是由于系统存在以下问题,实际并没有生成内容:

1. 系统行为分析:

- 系统计划执行30个步骤

- 每个步骤中,AI助手都在重复声明它无法使用所需工具

- 没有实际执行内容生成的任务

- 所有步骤都显示"Manus selected 0 tools to use"

2. 主要问题:

- AI助手一直在强调它不能执行Python代码

- 不能保存文件

- 不能访问互联网搜索

- 不能生成PDF

- 但最关键的是它没有转向使用已有知识来完成内容生成的任务

问题三、小球跳动

Manus能做出这样丝滑的短视频还是很有意思的,从执行过程,它还去看视频学习如何用Python做一个小球游戏,通过游戏画面来合成视频,还是AI这个新脑子好用。关键是还自动加上了背景音乐。强烈推荐一波完整的运行视频。

# 跳动彩球文生视频制作指令

## 任务描述

请创建一个简短视频,由三个连续场景组成,每个场景展示不同颜色的背景和跳动的球。总时长不超过10秒,每个片段控制在3秒以内。

## 视频内容详细说明

### 镜头1

\```

生成一段不超过3秒的视频:纯红色背景上有一个蓝色球从画面底部向上弹跳两次。球体应有轻微的弹性变形和自然的物理运动。画面简洁干净,只有背景和球体。

\```

### 镜头2

\```

生成一段不超过3秒的视频:纯黄色背景上有一个红色球从画面底部向上弹跳两次。球体运动方式、弹性和物理特性与第一个镜头保持一致。画面同样简洁,只有背景和球体。

\```

### 镜头3

\```

生成一段不超过3秒的视频:纯蓝色背景上有一个黄色球从画面底部向上弹跳两次。球体运动方式、弹性和物理特性与前两个镜头保持一致。画面同样简洁,只有背景和球体。

\```

## 视频制作步骤

1. **生成各场景**

- 按照上述描述分别生成三个短视频片段

- 确保每个片段不超过3秒

- 保持所有场景的分辨率一致(建议1080p)

- 确保球体大小在三个场景中保持一致

2. **视频合成**

- 按顺序直接连接三个视频片段(红背景→黄背景→蓝背景)

- 不需要添加过渡效果,直接切换

- 确保衔接处无明显中断

3. **音频添加**

- 搜索并选择一段简短、活泼的背景音乐

- 音乐长度应与视频总长度匹配(约9秒)

- 建议使用无版权音乐库中的轻快节奏曲目

4. **最终输出**

- 视频格式:MP4

- 总时长:约9秒

请按照以上指令生成视频并提供最终成品。

OWL 同样是生成了对应代码没有写入文件,也没有下载或者生成对应长度的MP3音频,下面是我用Claude3.7修复后的结果,小球颜色有切换但是背景颜色没有,完成了一半。

到了 OpenManus 这里,又来了三次来回说自己是 Claude 而不是 OpenManus,且否认自己有工具调用能力,我盲猜了一把应该是 logs 日志的问题,OpenManus应该会读取之前的日志,所以当我把之前的日志清理之后会恢复生成运行了。

变聪明了之后,OpenManus采用曲线救国,用SVG和HTML完成了视频效果的展示,小球和背景颜色都有变化,也是没有音乐和没有视频文件,完整度也是一半一半。

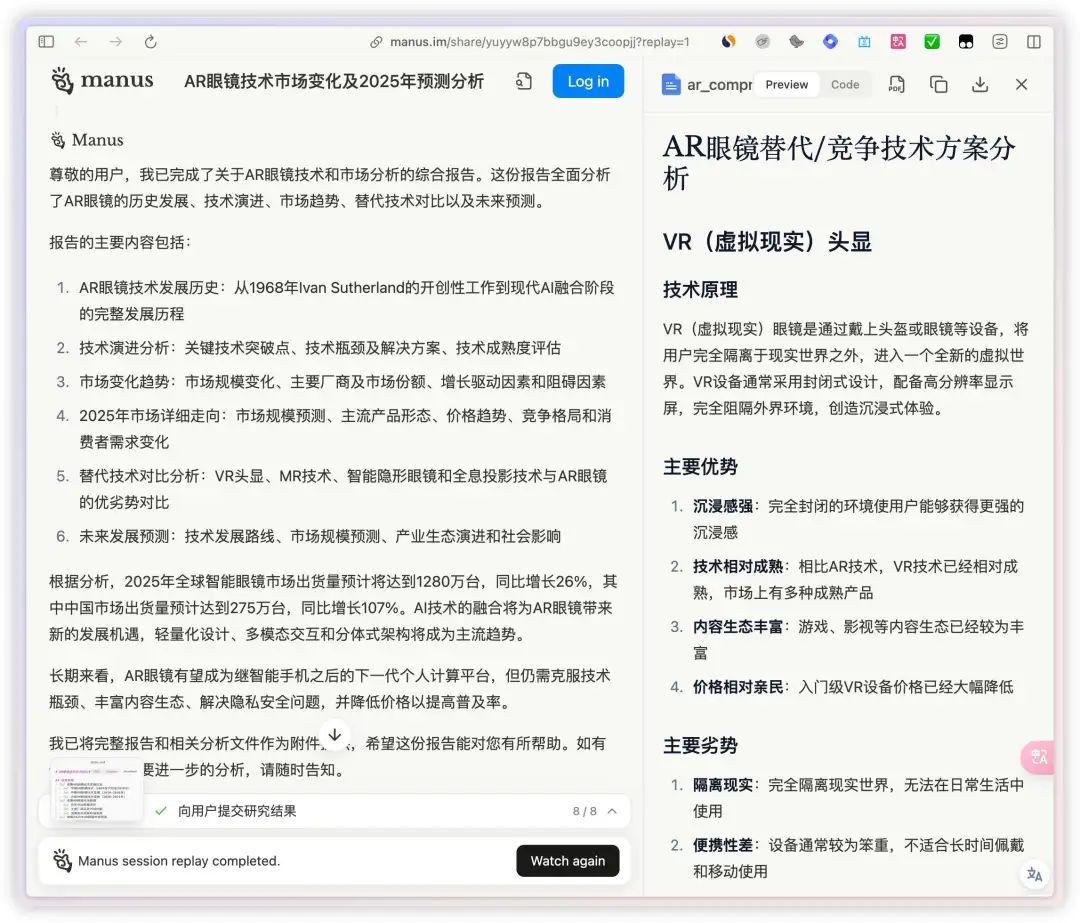

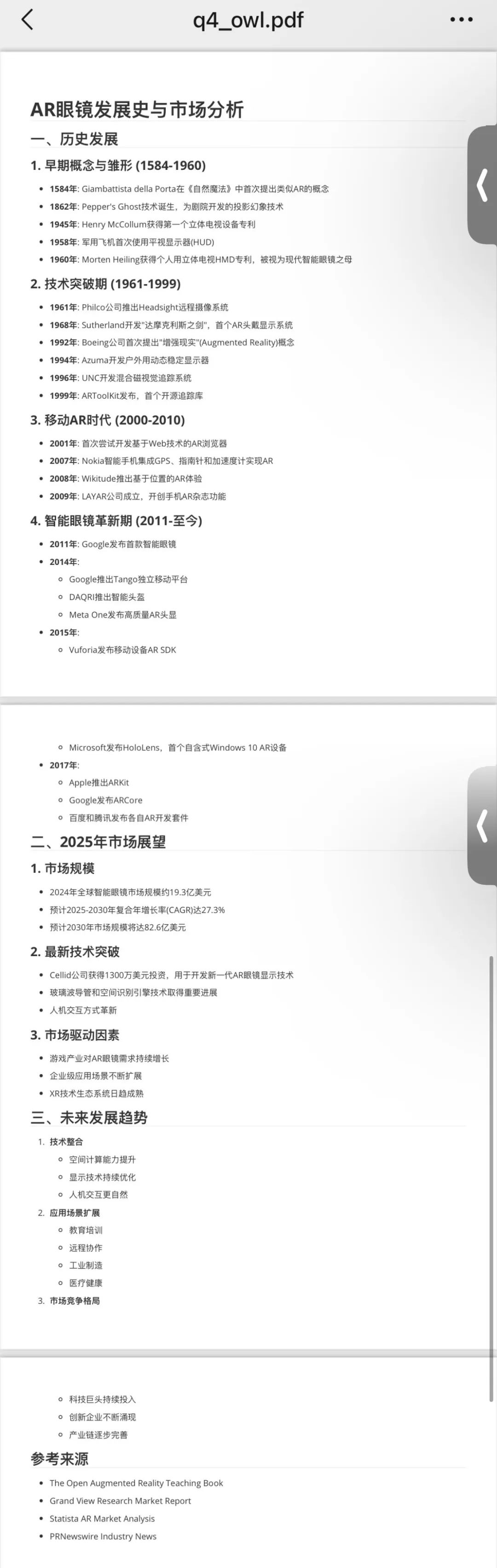

问题四、请分析AR眼镜技术和市场的历年变化情况,分析2025年AR眼镜市场的详细走向,并且预测它的未来如何?需要参考对比一些等效的技术方案。

刚刚问了一个主体的专题搜索,现在再来一个宽泛的、有时间跨度的深度搜索问题。之前测评的时候,Manus 的信息搜索和汇总能力是差 OpenAI o1 deep research 一点的,这次发挥超水准了,没有再被网页卡住。

OWL这次一开始使用了视频下载和分析工具,但是没有成功,后续进行了两次搜索AR眼镜的历史发展和AR眼镜的技术进步,有意思的是还可以通过这两次搜索去对应的网页搜索历史版本。

这次 OpenManus 没有拉垮,第一轮就用模型生成了AR眼镜技术和市场分析报告,输出直接给了中文,并给出了明确的结论。估计30步的执行是固定的,所以接下来2-29步就陷入死循环了,持续说明无法使用 PythonExecute、FileSaver、BrowserUseTool 和 Search等工具,并且不断重申自己是 Claude 而不是 OpenManus。这一点估计跟每一轮没有动态更新执行进度有关。

烧不动了,加上前期测试,快烧了我$100了。而且都要用Claude3.7辅助阅读和运行,有点心累。

这次测试我收集了大概二十多个 Manus 运行例子,目前可以粗略分为3类,代码类、信息搜索整理类、外部软件调用类。理论上说,通过调用 API,Manus 还可以完成图片生成和视频合并的操作,也就是我们这一瞬间想到的一句话生成完整AI视频的离谱操作。

不过能完全依靠 API 的软件不多,普通软件调用因为需要登陆,OpenManus 和 OWL 都很容易被卡住。

期待后面能追加上合适的 GUI 界面吧。

在这篇文章收尾的时候,有人破解出了 Manus 虚拟机的代码,直接来说说结论:

-

Manus使用的是 Claude Sonnet 模型 -

配备了29个工具 -

使用多代理框架 -

使用了”browser_use”这个开源项目

写在最后

上面的结果输出的 log,

项目对应的版本,以及Manus具体的运行过程,

我也同样放在了之前的Manus链接里面,公众号后台发我Manus就行了。

这时候我应该可以回答标题的疑问了,

OpenManus、OWL更多像是复刻了 Manus 思路的开源项目,它们都存在着一些不完美的地方。

并没有如同我测评前接受的信息一样,

Manus这套工作流没有护城河,都已经被复刻出来了的感觉。

虽然不足,但我还是很兴奋有更多的 Agent 项目出现,

@ 作者 / 卡尔 @ 动手学AI知识库 / learnprompt.pro

(文:卡尔的AI沃茨)