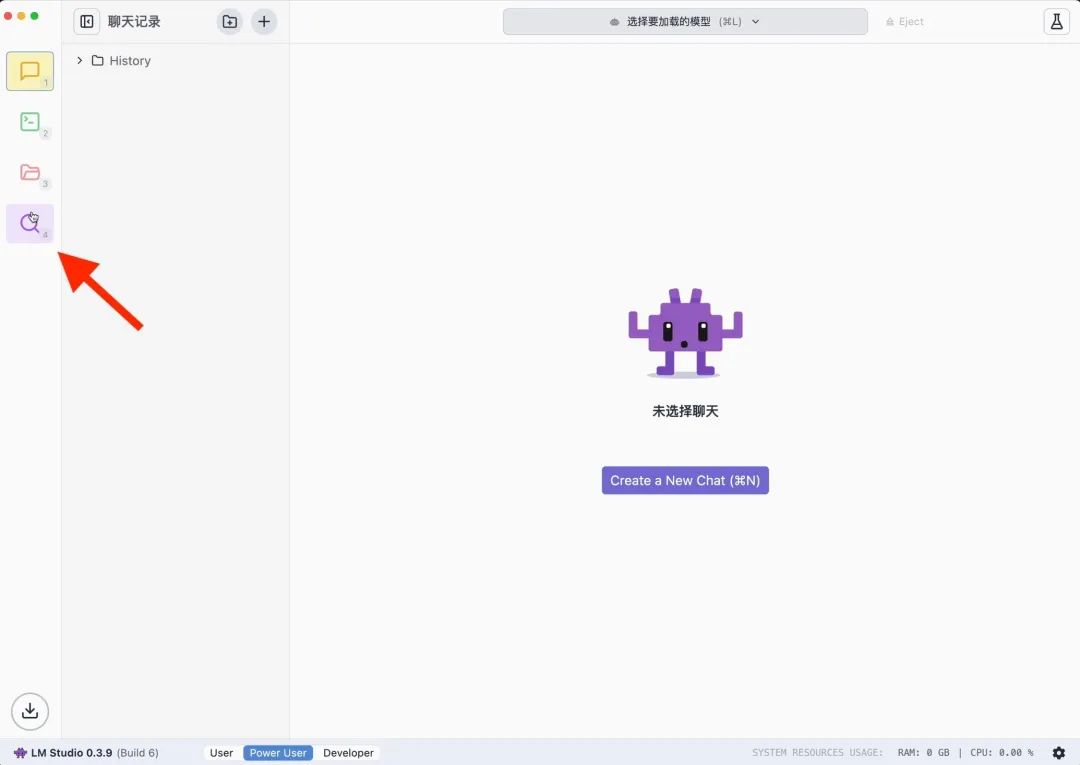

LM Studio

首先登场的是小白极简版本,在官网(lmstudio.ai)根据个人电脑型号下载 LM Studio,接着为了方便使用,建议点击右下角修改语言为简体中文。

然后搜索 deepseek-r1 选择合适的版本下载,作为示例,我选择使用阿里 Qwen 模型为基座蒸馏出来的 7B 小模型。

配置完成后,即可一键启动。

使用 LM Studio 的好处就是不用代码、界面友好,但跑大型模型的时候对性能要求高,因此更适合新手入门使用基础功能。

当然,对于追求更深层次体验的用户,我们也准备了进阶方案。

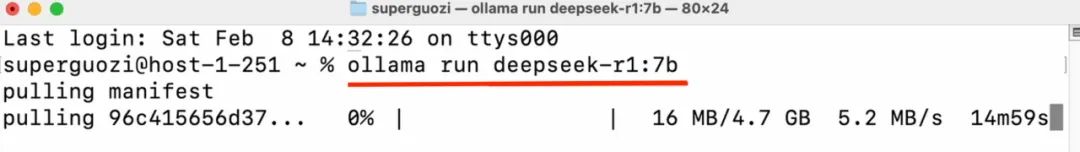

首先从官网(ollama.com)获取并安装 Ollama。

启动后打开命令行工具。Mac 用户键盘 Command+空格 打开「终端」工具,Windows 用户键盘运行 Win+R ,输入 cmd 打开「命令提示符」工具。

在窗口中输入代码指令(ollama run deepseek-r1:7b)即可开始下载。请注意英文状态输入,检查空格和横杠,冒号后输入所需要的版本名称。

配置完成后就能在命令行窗口开始对话。

这个方法对性能要求很低,但需要熟悉命令行操作,模型的兼容性也有限,更适合进阶开发者实现高级操作。

如果你想要比较好看的交互界面,不妨在 Chrome 浏览器安装插件,搜索安装 PageAssist。

选择本地已安装的模型,开始使用。

右上角设置里修改好语言,主页选择模型就可以开始对话,而且支持基础的联网搜索,玩法也更多样。

5. 此外,我们注意到 DeepSeek-R1 系列模型在响应某些查询时,可能会绕过思维模式(即输出 「\n\n」),这可能会影响模型的性能。为了确保模型进行充分的推理,我们建议在每次输出的开始,强制模型以 「\n」 开始其响应。

DeepSeek-R1-Distill-Llama-70B

DeepSeek-R1-Distill-Qwen-32B

DeepSeek-R1-Distill-Llama-70B

DeepSeek-R1-Distill-Llama-70B

本地部署最常用的功能当属打造自己的知识库,方法则是在安装 LM Studio 之后,增加与 Anything LLM 联动的部署步骤。

https://x.com/carrigmat/status/1884244369907278106

答: DeepSeek 的完整版对电脑要求较高,但是,如果你只是想用它进行简单的操作,可以选择一些蒸馏小模型,不过仍需量力而行。

答: 蒸馏版模型是 DeepSeek R1 的简化版本,硬件要求更低,运行起来速度也更快。

答: 如果你选择本地部署 DeepSeek,那么在没有互联网的情况下也能使用它。如果你通过云端或第三方平台使用,就需要网络连接才能访问。

答: 如果你选择本地部署 DeepSeek,那么你的数据不会上传到云端,更加安全。如果使用在线版本,确保选择可信的服务平台,保护个人隐私。

(文:APPSO)