新智元报道

新智元报道

【新智元导读】北大DeepSeek联合发布的NSA论文,目前已被ACL 2025录用并获得了极高评分,甚至有望冲击最佳论文奖。该技术颠覆传统注意力机制,实现算力效率飞跃,被誉为长文本处理的革命性突破。

重磅惊喜!

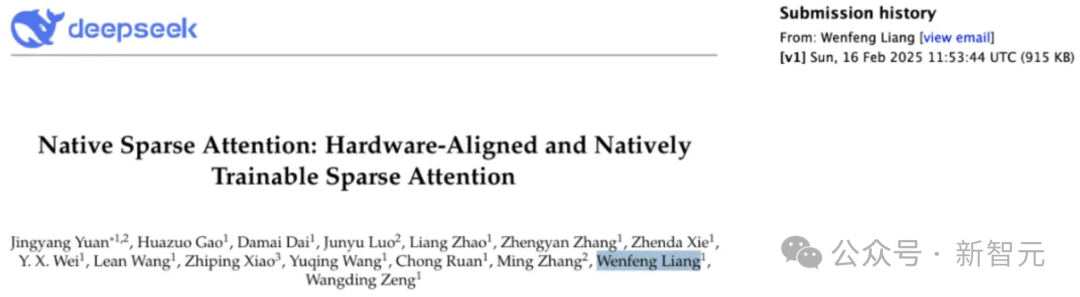

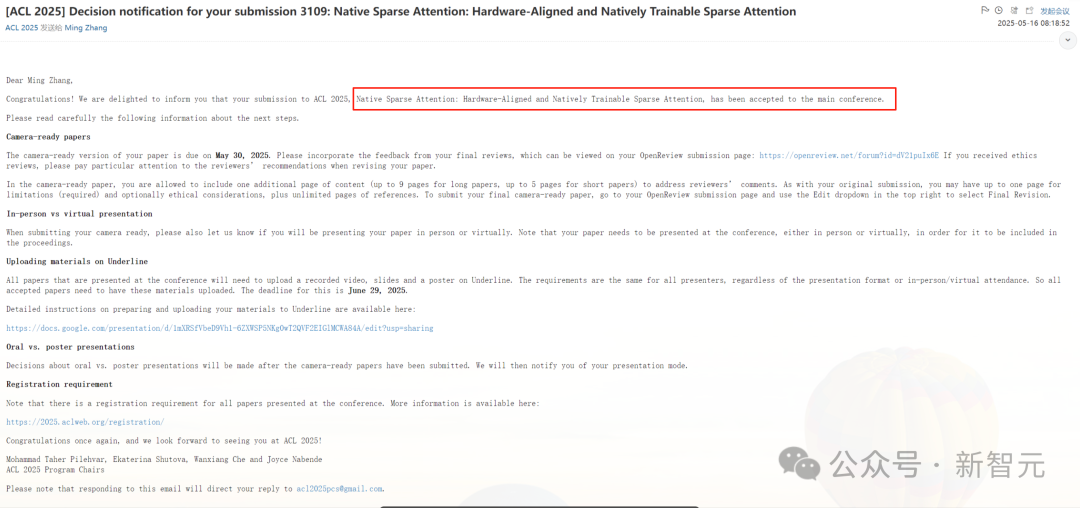

北大与DeepSeek合作,并由梁文锋亲自提交到arXiv的论文,将有望斩获ACL 2025最佳论文(ACL Best Paper)。

论文地址:https://arxiv.org/abs/2502.11089

要知道今年的ACL格外的卷,总投稿数高达8000多篇,创历史之最,而ACL 2024总投稿数仅为4407,几乎翻倍!

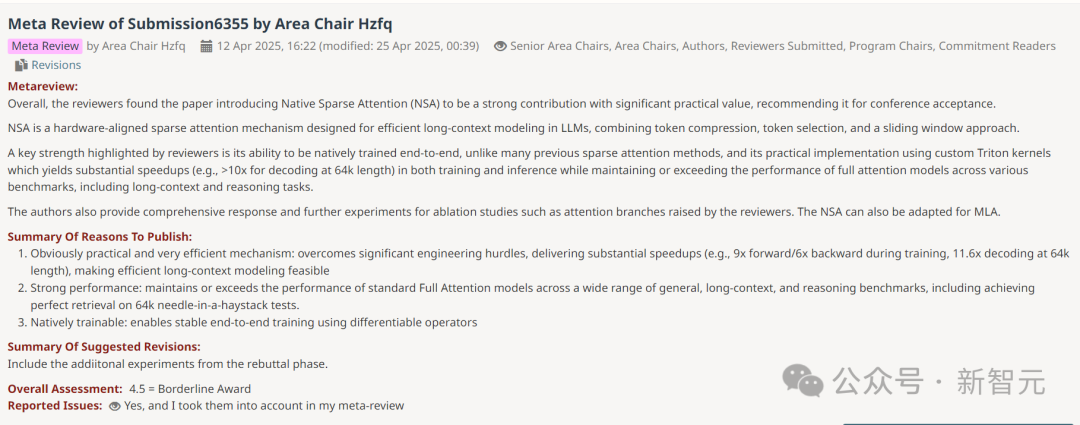

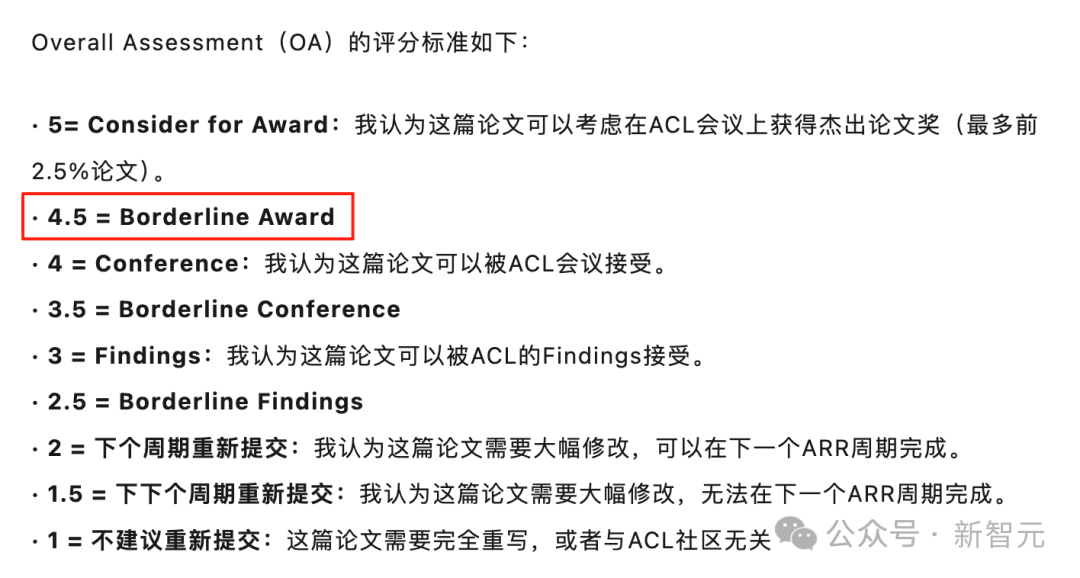

原生稀疏注意力(Native Sparse Attention,NSA)论文的Meta Review的OA分数已经确认得到了4.5分,这是一个相当高的分数,满分为5分。

按照ACL的OA评分标准,4.5分已经获得了Borderline Award,也就是说非常有望获得ACL这届的最佳论文。

这篇论文的发布在当时引起广泛的社区关注,NSA把AI行业的焦点从「模型规模竞赛」拉向「算力效率竞赛」,堪称2025年上半年最具杠杆效应的底层技术突破之一。

DeepSeek-R1的发布引发了AI行业的「价值重估」,DeepSeek用「低成本+同效能」的开源技术撼动了当时AI界人们固有的「有卡才行」的认知。

而NSA技术进一步实现了「长下文的算力平权」,让开源模型也能达到闭源模型(ChatGPT、Gemini等)才能满足的上下文窗口。

NSA将长文本处理速度提高了最多11倍,该方法结合了算法创新和改进的硬件,提高效率而不用牺牲硬件性能。

NSA的出现,是对传统注意力机制的一次革新,传统模型依赖于全注意力机制,将每个Token与其他所有Token进行比较。

传统机制虽然对于短篇文本有效,但随着文本长度的增加,这一过程会显著变慢,并且计算成本变得非常高。

NSA是DeepSeek-R1「爆火出圈」后的第一篇论文,同时在NSA发布一周后,DeepSeek进行了更广为人知的「开源周」活动分享。

为什么要革新传统的注意力机制?

长文本处理能力是新一代语言模型的关键需求,但传统注意力机制带来的巨大计算开销一直是一个棘手的问题。

在这种背景下,稀疏注意力机制展现出了提升计算效率同时又能保持模型性能的巨大潜力。

北大和DeepSeek提出名为NSA的创新性稀疏注意力机制,它能够原生支持训练,通过将算法创新与硬件优化相结合,实现了高效的长文本处理。

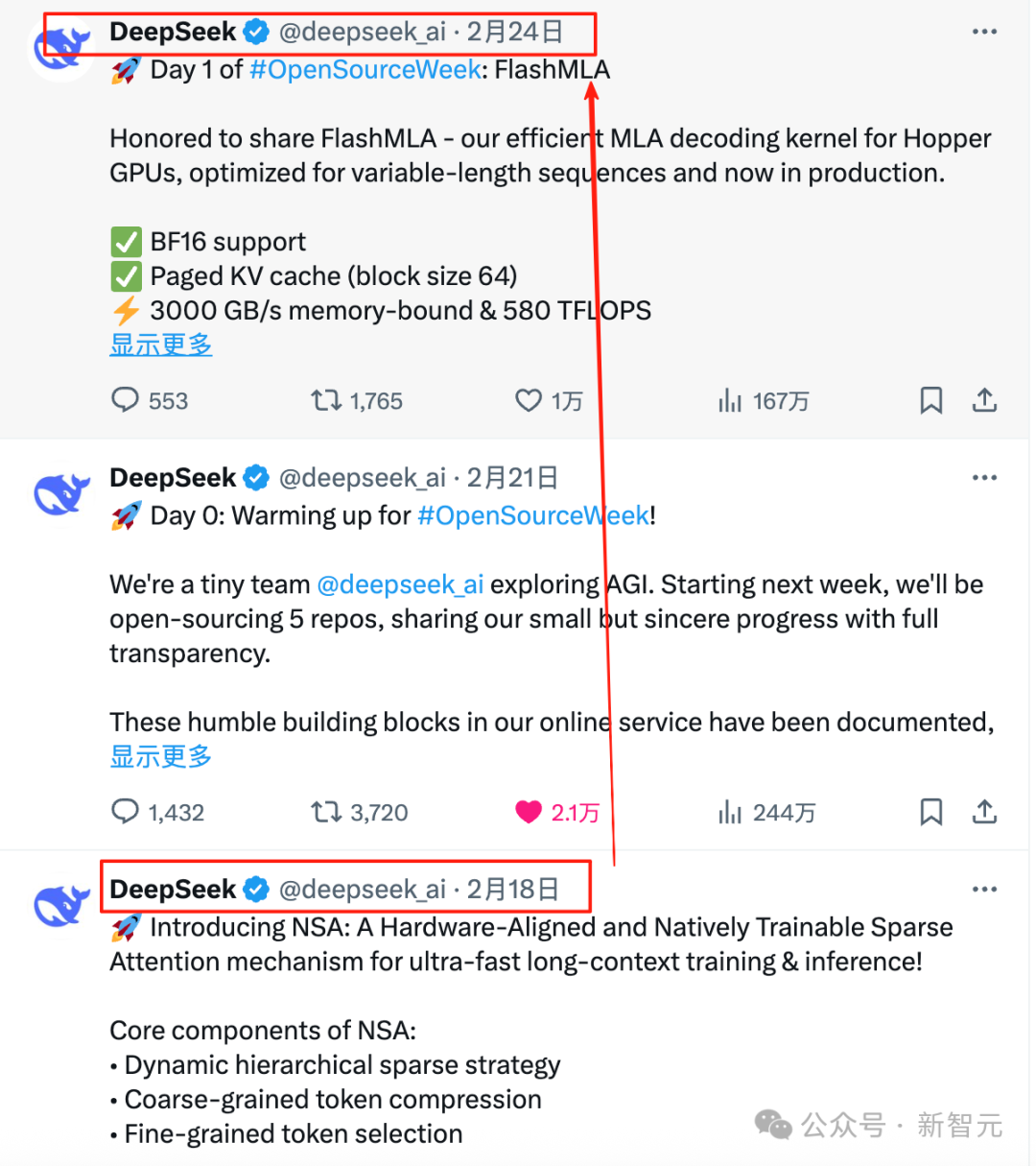

NSA采用了动态分层的稀疏策略:在保证全局信息获取的同时,还能够精确捕捉局部细节,这得益于其巧妙结合了粗粒度的令牌压缩和细粒度的令牌选择。

NSA架构如下图所示,通过三条并行的注意力分支来处理输入序列。对于每一个查询(query),前面的键(key)和值(value)会分别被处理成三种不同的注意力方式:

-

压缩注意力(Compressed Attention),用于捕捉粗粒度的整体模式;

-

选择性注意力(Selected Attention),专注于重要的词块;

-

滑动注意力(Sliding Attention),负责获取局部上下文信息。

每条分支所生成的不同注意力模式。图中的绿色区域表示需要计算注意力分数的部分,而白色区域则是可以跳过、不计算的区域。

NSA的主要创新点有两个:一是通过精心设计的算法平衡了计算密度,并针对现代硬件做了专门优化,显著提升了运行速度;二是实现了端到端的训练模式,在确保模型性能的前提下大幅降低了预训练的计算量。

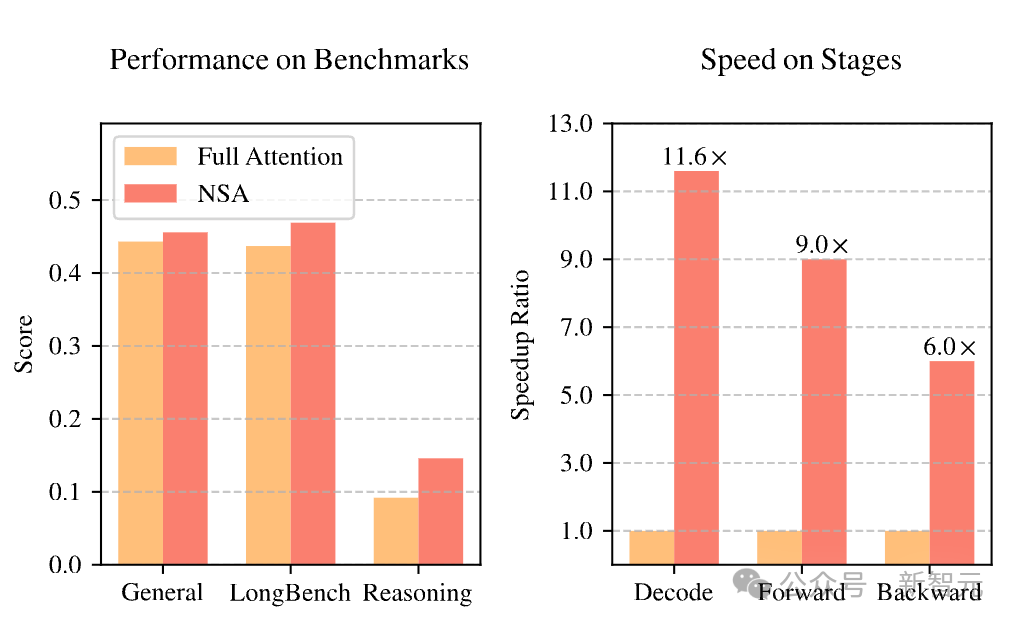

如图1所示,实验结果显示:采用NSA预训练的模型在通用基准测试、长文本处理和指令推理等多个任务上,性能均达到或超过了使用完整注意力机制的模型。

此外,在处理64k长度序列时,无论是decoding、前向传播还是反向传播,NSA都展现出了显著的速度优势,充分证明了它在模型全生命周期中的高效性。

该论文第一作者为北京大学计算机学院硕士生袁境阳(北京大学,导师为张铭教授),合作者包括高华佐(DeepSeek),代达劢(DeepSeek),罗钧宇(北京大学)、肖之屏(华盛顿大学)等。

通讯作者为梁文锋(DeepSeek),曾旺丁(DeepSeek),张铭教授(北京大学)。

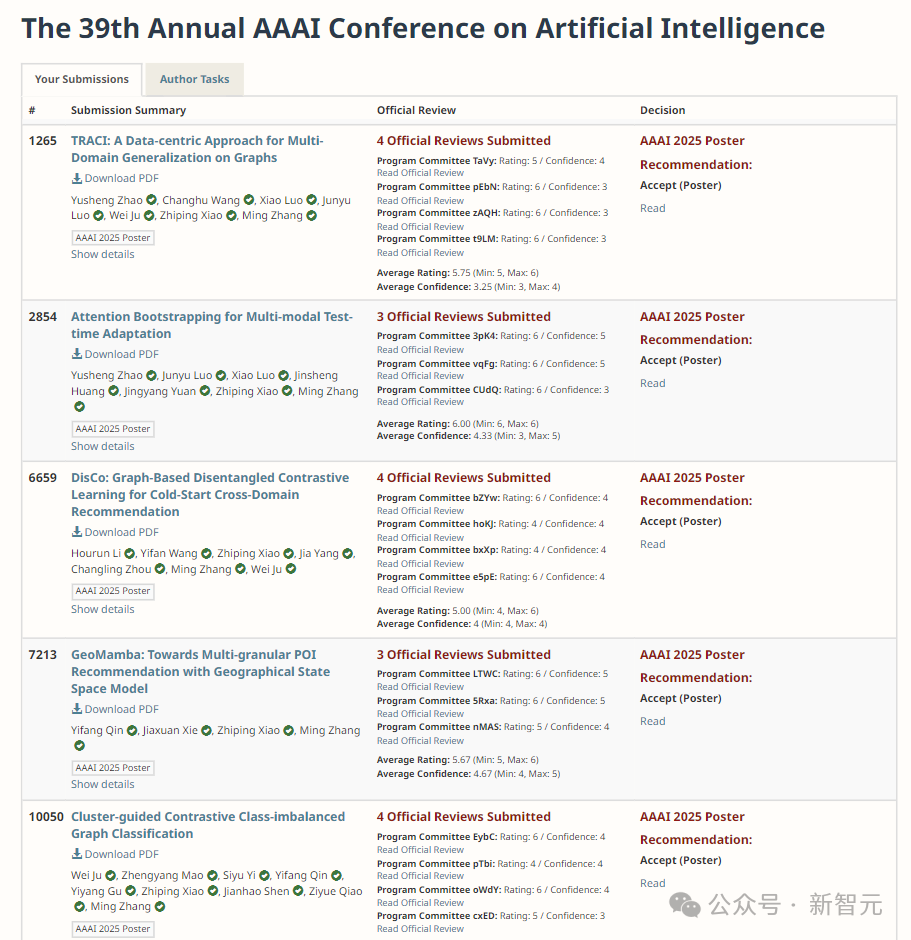

除了NSA论文外,北京大学张铭教授团队的其他论文也同样上榜。

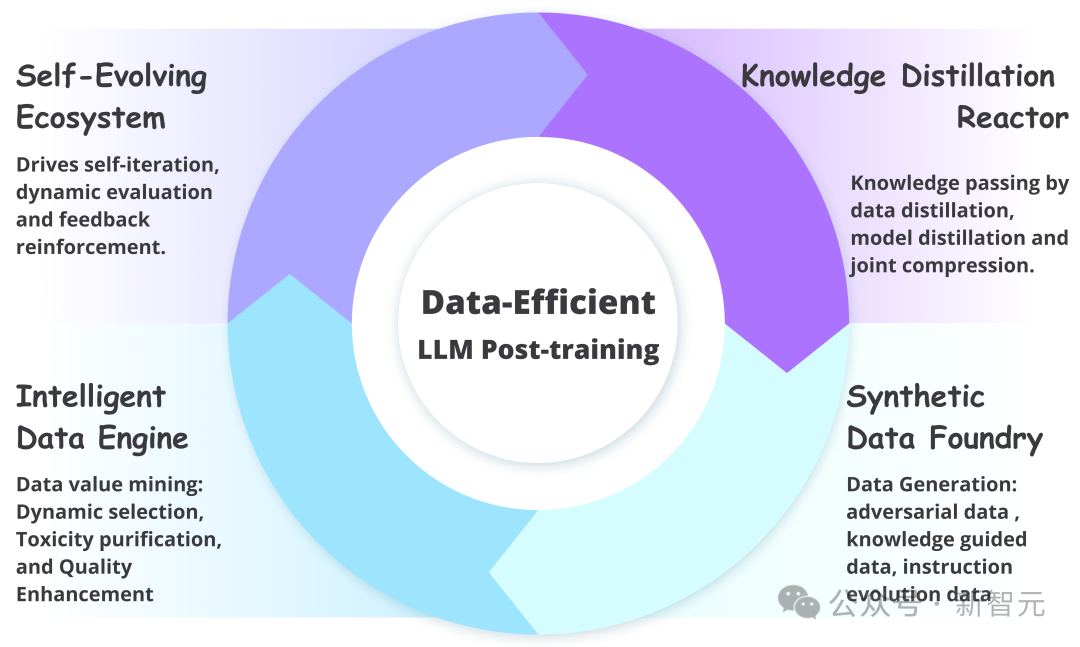

论文名: A Survey on Efficient LLM Training: From Data-centric Perspectives

这是首个从数据中心视角系统性剖析LLM高效后训练的综述。

该文创新性地提出了一个涵盖数据选择、质量增强、合成数据生成、数据蒸馏与压缩及自演化数据生态的分类框架,深入总结了各领域代表性方法并展望未来研究方向,旨在为学界和业界探索大规模模型训练中数据利用的最大潜力提供关键启示。

该论文作者包含罗钧宇(北京大学,导师为张铭教授),吴伯涵(北京大学),罗霄(UCLA),肖之屏(华盛顿大学),靳轶乔(佐治亚理工),涂荣成(南洋理工大学),尹楠(HKUST),王一帆(对外经贸),袁境阳(北京大学),琚玮(四川大学),张铭(北京大学,通讯作者)。

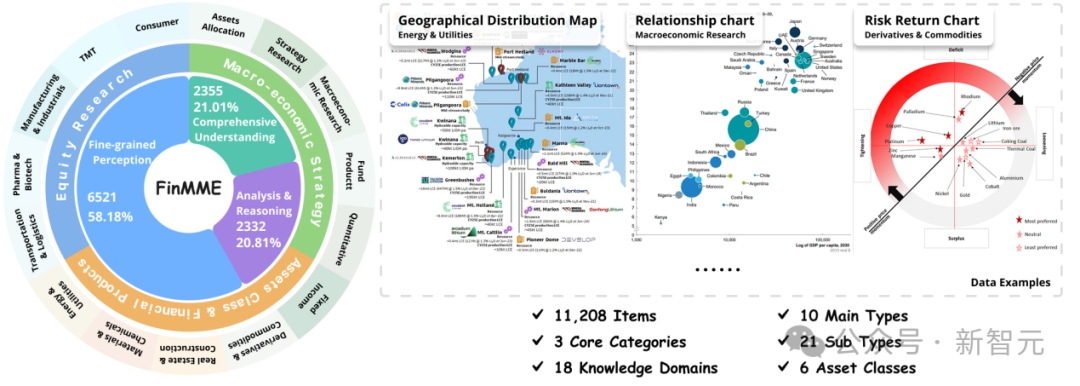

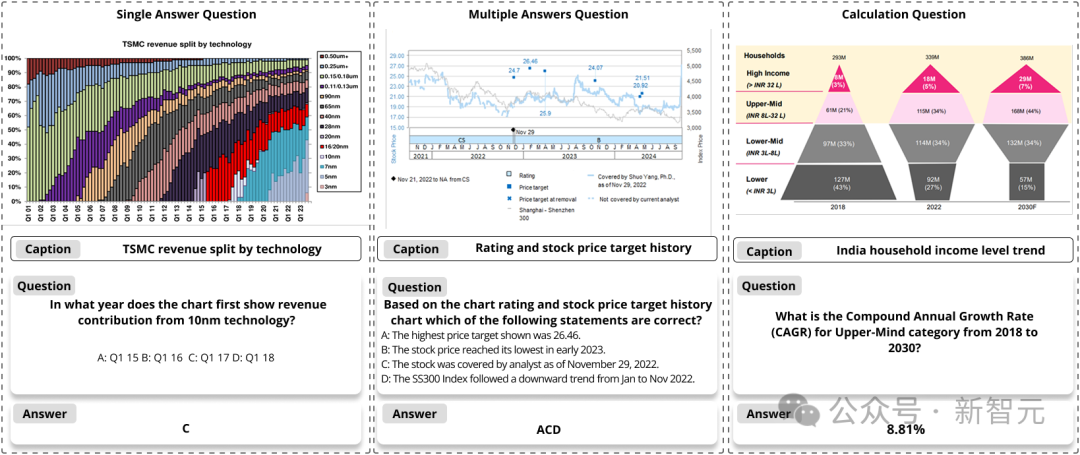

论文名:FinMME: A Financial Multi-Modal Evaluation Dataset

为应对金融领域多模态大模型评估的迫切需求,并提供高质量的多模态推理验证数据集。

北京大学Dlib实验室联合香港科技大学等重磅推出了首个大规模、高质量的金融多模态评估数据集FinMME。

该数据集包含超过11,200个金融研究样本,覆盖18个核心金融领域和10种主要图表类型,并引入独创的FinScore评估系统。

实验结果表明,即便是顶尖模型如GPT-4o在FinMME上也面临显著挑战,凸显了其在衡量金融多模态理解与推理能力方面的深度与价值。

论文作者包含罗钧宇(北京大学,导师为张铭教授),寇智卓(HKUST),杨礼铭(北京大学),罗霄(UCLA),黄进晟(北京大学),肖之屏(华盛顿大学),彭靖姝(HKUST),刘程中(HKUST),吉嘉铭(HKUST),刘譞哲(北京大学),韩斯睿(HKUST),张铭(北京大学,通讯作者),郭毅可(HKUST)。

该论文涉及大语言模型中的数学推理增强方法。思维链(CoT)提示已成为激发大语言模型(LLM)推理能力的核心方法,但其生成的推理步骤中存在难以检测的「幻觉」。

现有的消除大语言模型幻觉的方法如过程奖励模型(Process Reward Model)或自一致性校验如同黑箱操作,难以提供可验证的证据,制约了纠正幻觉的能力。

论文提出一种创新的Safe验证框架。区别于传统模糊评分机制,Safe创新性地证明验证定理的正确性,从根本上识别并消除幻觉。实验表明,本论文提出的Safe验证框架在多个数学模型和数据集上实现显著性能提升,实现神经符号系统在数学推理中的有机融合。

本研究回归了形式数学语言的初衷——为人类易错的证明过程提供坚实保障。Safe框架为数学教育、代码生成等高风险领域提供了可验证的推理解决方案。

该论文第一作者为数据科学与工程所博士生刘成武(北京大学,导师为张铭教授),合作者包括袁野(北京大学)、尹伊淳(华为诺亚方舟实验室)、许妍(华为诺亚方舟实验室)、许鑫(香港科技大学)、陈造宇(香港理工大学)、尚利峰(华为诺亚方舟实验室)、刘群(华为诺亚方舟实验室)、张铭(北京大学,通讯作者)。

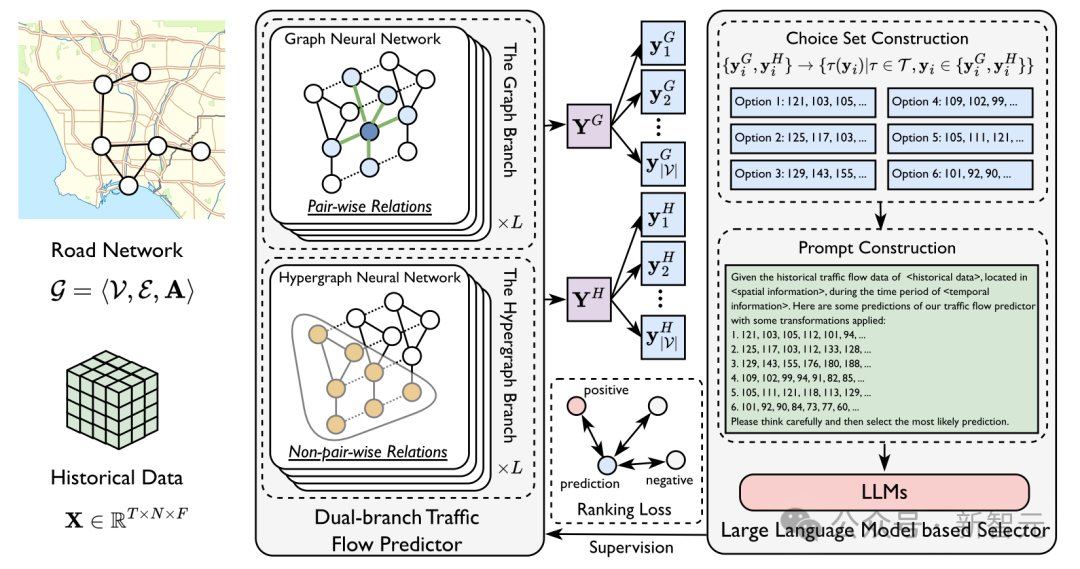

论文名: Embracing Large Language Models in Traffic Flow Forecasting

交通流量预测旨在基于历史交通状况和路网结构,预测未来交通流量,这是智能交通系统中的关键问题。

现有方法主要聚焦于捕捉和利用时空依赖性来进行流量预测,尽管取得了一定进展,但在面对测试时交通条件变化时表现不足。

针对这一挑战,本文提出了一种基于大语言模型(LLM)的新方法——LEAF (Large Language Model Enhanced Traffic Flow Predictor)。

与以往工作主要使用LLM的生成能力来直接生成未来交通流量序列不同,LEAF使用LLM的判别能力。

具体来说,LEAF采用双分支结构,分别通过图结构和超图结构捕捉不同的时空关系。两个分支在预训练阶段独立训练,并在测试时生成不同的预测结果。

随后,利用大语言模型从这些预测中选择最有可能的结果,并通过排序损失函数作为学习目标来增强两个分支的预测能力。在多个数据集上的广泛实验验证了LEAF的有效性,证明其在流量预测任务中能够更好地适应测试环境变化。

该论文第一作者为数据科学与工程所博士生赵禹昇(北京大学,导师为张铭教授),合作者包括罗霄(加州大学洛杉矶分校)、温浩珉(卡耐基梅隆大学)、肖之屏(华盛顿大学)、琚玮(四川大学),张铭(北京大学,通讯作者)。

袁境阳

北京大学计算机学院研究生,导师为张铭教授。

主要研究方向是高效大语言模型和稀疏注意力机制,曾获北京市优秀毕业生、北京大学优秀毕业生等称号。

罗钧宇

北京大学计算机学院博士生,导师为张铭教授。

他的研究方向关注于高效的LLM、LLM后训练、自适应学习等。

在ICML,CVPR,ACL,TPAMI等顶级刊物上以第一作者发表多篇文章。

赵禹昇

北京大学计算机学院研究生,导师为张铭教授。

研究方向包括图神经网络、时空预测、多模态等,关注测试数据的分布偏移问题。

刘成武

北京大学计算机学院数据科学与工程所博士生,导师是DLIB实验室的张铭教授。

他的研究方向是自然语言处理、大语言模型的数学推理和自动定理证明。

他在北京大学外国语学院获得了文学学士学位,并修读获得了信息科学技术学院的计算机科学与技术双学位。

张铭

北京大学计算机学院二级教授,博士生导师,北大-安克大模型算法与应用联合实验室主任。2021年CCF杰出教育奖获得者。

张铭教授本硕博都毕业于北京大学计算机系,长期致力于机器学习、图神经网络、知识图谱、文本挖掘、语言模型、推荐系统、教育大数据、科学智能等相关研究。

先后主持国家重点研发计划课题、国家自然科学基金等前沿项目,发表科研论文 300 多篇,谷歌学术被引用21800余次。合作提出的LINE模型是图机器学习领域著名的的基准模型,目前单篇被引用 6700 余次。

获得了机器学习顶级会议ICML 2014唯一的最佳论文奖,以及WWW 2016 最佳论文提名。

在近期利用率仅为20%左右的几大顶会中,张铭教授的课题组的中概率都在50%以上。

其中,在ICML 2025中了4篇论文。

AAAI 2025也是5篇上榜。

还有ICLR 1篇,KDD 1篇,NAACL 1篇主会 2篇Finding。

(文:新智元)