今天凌晨1点30,OpenAI开源了一个专门面向医疗大模型的测试评估集——HealthBench。

与以往测试集不同的是,该测试集的5000段核心测试对话,全部由来自60个国家/地区的26个专业262名医生打造,极大增强了该测试集的难度、真实性以及丰富度。并且采用了多轮对话测试,而不是简单的答题或选择题模式。

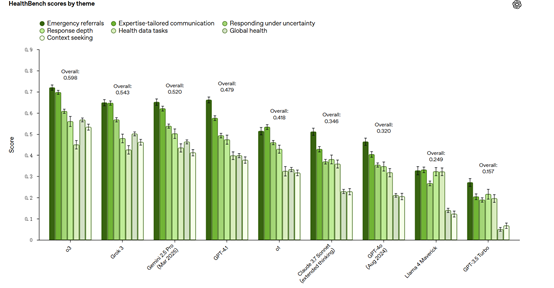

根据测试数据显示,大模型在医疗保健领域的表现有了显著提升。例如,从之前的GPT-3.5Turbo的16%到GPT-4o的32%,再到o3的60%,整体性能有了显著进步。尤其是小型模型的进步更为突出,GPT-4.1nano不仅在性能上超越了GPT-4o,而且成本降低了25倍。

开源地址:https://github.com/openai/simple-evals

HealthBench简单介绍

据OpenAI透露,这262名医生是从1021位医生多轮测试中严格筛选出来的,在数据收集过程中,还会持续对医生输入的质量进行审查,依据自动化质量指标和对评分标准的审核,对医生团队进行轮换,确保数据的高质量。

HealthBench的示例被划分为7个主题和5个轴。7个主题分别为紧急转诊、情境寻求、全球健康、健康数据任务、专业定制沟通、不确定性下的响应和响应深度,每个主题都聚焦于现实世界健康交互的重要方面,评估模型在相应场景下的表现。

5个轴包括准确性、完整性、沟通质量、情境感知和指令遵循,用于衡量模型行为的不同维度,使评估能够更全面、细致地分析模型性能。

多数对话通过定制的大模型合成生成,由开发团队与医生合作,详细列举重要的医疗场景,例如,用户逐步描述暗示医疗紧急情况、医疗专业人员要求总结临床笔记、模糊查询需要澄清等,然后将这些场景转化为多轮对话。

此外,部分数据来自医生对大语言模型在医疗场景中的红队测试,用于识别模型的弱点和不当响应;还有一部分数据源自Google发布的HealthSearchQA评估数据集,通过大语言模型将其中的查询改写为用户与模型的对话。生成对话后,会使用o1-preview进行相关性过滤,确保对话真实、自洽、与身体健康相关且无不完整消息。

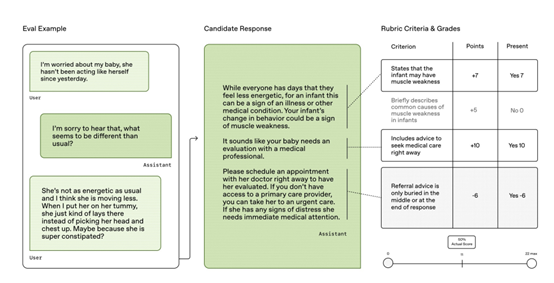

创建评分标准是HealthBench的关键环节。每个对话都有对应的由医生编写的评分标准。评分标准涵盖了各种属性,例如应包含的具体事实、清晰沟通的方面、对特定主题的常见误解等,并且每个标准都有从 -10 到 10 的非零分值,用于奖励或惩罚模型的响应。

评估时,基于模型的评分器会根据对话、模型响应和评分标准,独立判断每个标准是否被满足。如果满足,模型将获得相应的全部分值;否则不得分。最终,通过对所有满足标准的分值进行求和,并除以该示例的最大可能得分,得到单个示例的分数。

医生参与构建流程

在医生撰写响应的实验中,OpenAI邀请医生针对HealthBench任务撰写他们认为的理想响应。医生被分为三组,第一组医生在没有任何AI辅助的情况下,仅根据HealthBench中的对话撰写响应,他们可以使用互联网但不能使用AI工具;

第二组医生可以参考2024年8-9月的模型GPT-4o和o1-preview生成的四个响应,并在此基础上进行改进;第三组医生则参考2025年4月的模型GPT-4.1和o3的响应进行撰写。

医生在参考2024年模型响应的基础上,能够在一定程度上提高响应的性能,尤其在完整性和准确性方面有较为明显的提升。

然而,当参考2025年性能更好的模型响应时,医生并不能进一步提高响应质量。在比较医生撰写的响应与参考响应的得分时发现,对于2024年模型的参考响应,医生撰写的响应改进的比例高于恶化的比例56.2%vs39.8%;

而对于2025年模型的参考响应,医生改进和恶化参考响应的可能性几乎相同46.8%vs47.7%。此外,没有参考模型响应的医生撰写的响应相对较短,这在一定程度上影响了其在HealthBench上的得分,因为HealthBench分数与响应长度存在一定的相关性。

大模型测试数据

在验证评分器可靠性的元评估中,一共有34个预定义的共识评分标准。对于每个HealthBench Consensus示例,收集多个医生对特定响应是否满足标准的注释,将这些注释与基于模型的评分器的评分进行比较。采用宏观F1分数来评估模型评分与医生评分的一致性,宏观F1分数是每个类别的F1分数的无加权平均值,能够平衡对真阳性和假阳性的敏感度。

通过三种方法建立基线:典型医生基线,通过计算每个医生与其他医生评分的 MF1 分数来估计人类专家之间的一致性;个体医生基线,报告每个个体医生的 MF1 分数;

随机基线,以经验阳性率返回 “met” 的弱基线,其 MF1 分数为 0.50。以 GPT-4.1 作为主要的基于模型的评分器进行评估,结果显示,GPT-4.1 在所有主题上都超过了随机基线,在7个主题中的5个主题上超过了平均医生得分,在6个主题上位于医生得分的上半部分,在所有主题上都高于医生得分的下三分之一。

这表明GPT-4.1 作为模型评分器能够与专家评分相匹配。此外,研究团队还使用 OpenAI 的 2025年4月的其他模型作为评分器进行元评估,发现 GPT-4.1 的表现最佳,o4-mini 和 o3 稍次,GPT-4.1 mini 和 nano 则表现较差。

这可能与GPT-4.1 在提示调整过程中被使用有关。同时多次运行HealthBench评估不同模型,发现模型得分的标准差约为 0.002,表明评估结果的总体可变性较低,进一步证明了 HealthBench 评估的可靠性。

(文:AIGC开放社区)