关注我,记得标星⭐️不迷路哦~

关注我,记得标星⭐️不迷路哦~

✨ 1: DeepWiki

DeepWiki是一款AI驱动的工具,能为GitHub等代码仓库自动创建精美、交互式Wiki文档,并生成可视化图表。

DeepWiki 是一个可以为 GitHub、GitLab 或 BitBucket 仓库自动创建美观且交互式 Wiki 的工具。用户只需输入仓库名称,DeepWiki 就会自动分析代码结构,生成全面的文档,创建可视化图表解释代码的工作方式,并将所有内容组织成易于导航的 Wiki。

主要特点:

- 快速生成文档:

在几秒钟内将任何 GitHub、GitLab 或 BitBucket 仓库转换为 Wiki。 - 支持私有仓库:

使用个人访问令牌安全地访问私有仓库。 - 智能分析:

AI 驱动的代码结构和关系理解。 - 可视化图表:

自动生成 Mermaid 图表,可视化架构和数据流。 - 易于导航:

简单直观的界面用于浏览 Wiki。 - 提问功能:

使用 RAG (Retrieval Augmented Generation) 技术与你的代码仓库进行对话,获取准确的答案。 - 深度研究:

通过多轮研究过程深入调查复杂主题。

地址:https://github.com/AsyncFuncAI/deepwiki-open

✨ 2: Meeting Prep Agent

Meeting Prep Agent利用Tavily搜索和MCP,实时分析会议信息,助你充分准备会议。

Meeting Prep Agent 是一个利用 Tavily 的高级搜索功能,并结合 Google Calendar(通过 MCP)的会议信息,为用户准备会议的智能代理。它能实时访问网络,搜索会议参与者的个人资料以及相关公司的信息,帮助用户更好地了解会议背景和与会者,从而更有效地参与会议。这个项目旨在易于定制和扩展,方便用户集成内部数据源、修改代理架构或更换 LLM。

核心功能:

- 实时网络搜索:

使用 Tavily API 获取最新信息。 - 智能推理:

结合 MCP 和 ReAct 代理流程,提供上下文相关的智能响应。 - 流式子步骤:

以流的形式展示代理的推理过程和子步骤,提高透明度。 - 引用:

所有网络搜索结果都会被引用,方便验证。 - Google Calendar 集成:

通过 MCP 访问和分析会议数据。 - 异步 FastAPI 后端:

高性能、异步的后端,提供快速响应。 - 现代 React 前端:

交互式的 UI,提供动态的用户交互体验。

地址:https://github.com/tavily-ai/meeting-prep-agent

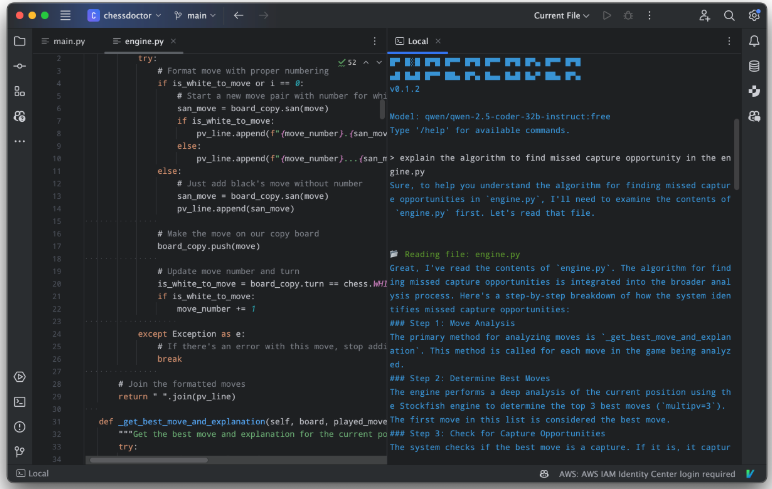

✨ 3: SuperCoder

SuperCoder是一款终端内运行的编码助手,具备代码搜索、编辑、修复等功能,简化开发流程。

SuperCoder 是一款在你的终端中运行的编码助手,旨在简化开发流程。它具备代码搜索、项目结构浏览、代码编辑、Bug修复等功能。你可以通过自然语言指令与它交互,例如搜索代码、编辑文件、查看项目结构等。SuperCoder 支持多种工具,包括代码搜索、代码编辑、文件读取、项目结构浏览和代码执行等。

地址:https://github.com/huytd/supercoder

✨ 4: MCP SuperAssistant Chrome Extension

MCP SuperAssistant是一个Chrome扩展,将MCP工具集成到ChatGPT等AI平台,增强其功能。

MCP SuperAssistant 是一款 Chrome 扩展程序,旨在将 Anthropic 开发的 Model Context Protocol (MCP) 集成到各种主流的 AI 平台中,如 ChatGPT、Google Gemini、Perplexity、Grok 等。 它的主要功能是在这些 AI 平台内,允许用户执行 MCP 工具,并将工具执行的结果无缝地插入回对话中,从而增强 AI 助手的能力。 这款扩展通过侧边栏UI,自动检测AI响应中的 MCP 工具调用,一键执行工具,并具有自动执行和提交模式,使用户能够更高效地与AI进行交互。 它还支持深色/浅色模式、偏好设置持久化,并提供了灵活的服务器连接选项。

地址:https://github.com/srbhptl39/MCP-SuperAssistant

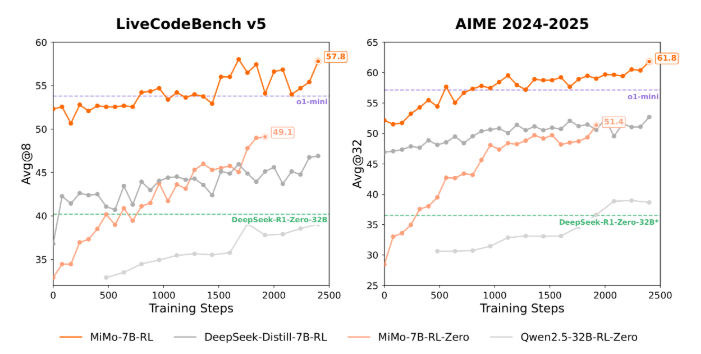

✨ 5: MiMo

MiMo是小米从头训练的7B模型,旨在通过预训练和后训练策略,释放语言模型的推理潜力。

MiMo (小米推理模型) 是一系列由小米开发的70亿参数的大语言模型,专注于提升语言模型的推理能力。MiMo 的核心理念是,要充分挖掘语言模型的推理潜力,不仅需要在后训练阶段进行优化,更要在预训练阶段就针对推理进行定制。

主要特点:

- 专为推理而生:

MiMo 在预训练阶段就注重提升推理能力,优化了数据处理流程,增加了预训练数据中推理模式的密度,并采用了多种策略来生成大量多样化的合成推理数据。 - 卓越的推理潜力:

实验表明,MiMo 即使是基础模型(MiMo-7B-Base),也展现了非凡的推理潜力,甚至超越了更大的32B模型。 - 强大的后训练:

MiMo 通过强化学习(RL)进行后训练,尤其是在数学和代码推理任务上表现出色。MiMo-7B-RL 在这两个任务上达到了与 OpenAI 的 o1-mini 相媲美的性能。 - 开放和可访问:

小米开源了 MiMo-7B 系列的多个模型,包括基础模型、SFT模型以及通过RL训练的模型。 - MTP (Multiple Token Prediction):

MiMo 模型架构中包含 MTP 层,这是一种预测多个token的技术,可以提高推理效率和模型性能。

地址:https://github.com/XiaomiMiMo/MiMo

(文:每日AI新工具)