在当今数字化时代,大型语言模型(LLMs)在自然语言处理领域取得了显著进展,但在实际应用中仍面临生成幻觉内容或信息过时等问题。为解决这一问题,检索增强生成(RAG)技术应运而生,通过整合外部知识提升模型的生成能力。然而,传统的检索增强方法依赖于与真实搜索引擎的交互,这不仅成本高昂,还存在文档质量不可控的问题。阿里巴巴通义实验室开源的 ZeroSearch 项目,提出了一种创新的解决方案,通过模拟搜索引擎的方式激励大模型的搜索能力,无需与真实搜索引擎交互,大幅降低了训练成本,同时提升了模型的推理能力。

一、项目概述

ZeroSearch 是阿里巴巴通义实验室开源的一种创新的大模型搜索引擎框架。它基于强化学习激励大模型的搜索能力,无需与真实搜索引擎交互,通过轻量级监督微调和课程学习机制,将大模型转化为检索模块,能够根据查询生成相关或噪声文档,并动态控制生成质量。该框架在多个问答数据集上的性能超过谷歌搜索,同时大幅降低了训练成本(超过80%),具有很强的扩展性和通用性。

二、主要功能

(一)无需真实搜索引擎交互

ZeroSearch 模拟搜索引擎的方式,避免了与真实搜索引擎(如谷歌)的交互,从而降低了成本和不可控性。通过这种方式,模型可以在本地环境中完成搜索任务,无需依赖外部API。

(二)动态控制文档质量

ZeroSearch 支持生成相关或噪声文档,能够通过调整提示中的关键词灵活控制生成文档的质量。这种机制为训练提供了多样化的检索场景,有助于提升模型的鲁棒性。

(三)大幅降低成本

相比使用真实搜索引擎进行强化学习训练,ZeroSearch 的训练成本大幅降低(超过80%)。这一特性使得大规模训练更加可行,尤其适合资源有限的研究者和开发者。

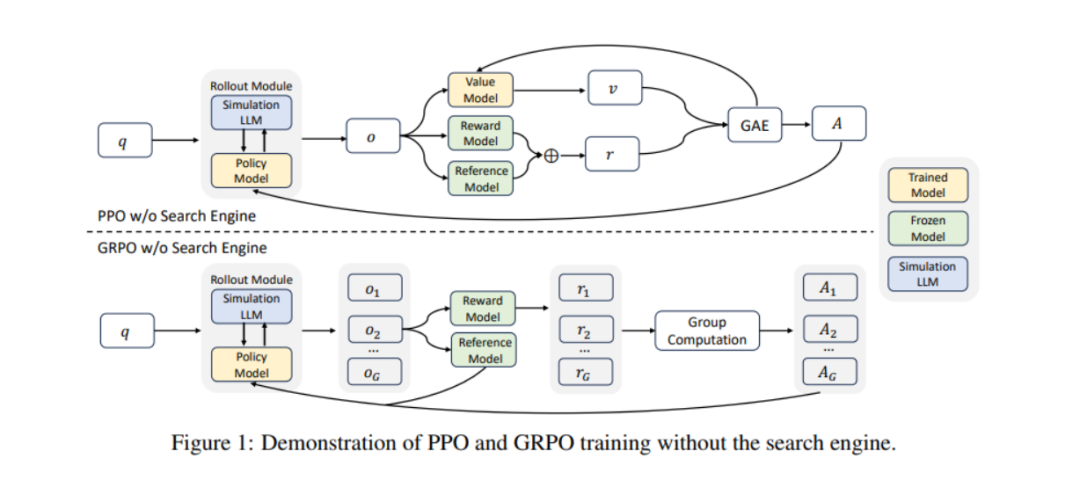

(四)支持多种模型和算法

ZeroSearch 兼容不同参数规模的大模型(如3B、7B、14B),并支持多种强化学习算法(如PPO、GRPO)。这种灵活性使得框架能够适应不同的应用场景和需求。

三、技术原理

(一)模拟搜索引擎

ZeroSearch 基于大模型自身的知识转化为模拟搜索引擎,根据查询生成相关或噪声文档,从而替代真实搜索引擎。通过这种方式,模型可以在本地环境中完成搜索任务,无需依赖外部API。

(二)轻量级监督微调

ZeroSearch 通过少量标注数据对大模型进行微调,使其能够生成高质量或低质量的文档,以适应不同的训练需求。这种微调机制不仅提升了模型的检索能力,还降低了训练成本。

(三)课程学习机制

在训练过程中,ZeroSearch 逐步增加文档的噪声水平,让模型从简单场景开始,逐步适应更具挑战性的任务。通过这种课程学习机制,模型的推理能力得到了显著提升。

(四)基于F1 分数的奖励机制

ZeroSearch 使用 F1 分数作为奖励信号,专注于答案的准确性。这种机制确保了模型生成的答案与真实答案尽可能匹配,从而提升了模型的整体性能。

(五)多轮交互模板

ZeroSearch 设计了明确的推理、搜索和回答阶段,通过结构化的标签(如 `<think>`、`<search>`、`<answer>`)引导模型逐步完成任务。这种多轮交互模板不仅提高了模型的透明度,还增强了其可靠性。

四、应用场景

(一)智能问答系统

ZeroSearch 可以快速准确地回答用户问题,适用于智能客服和智能助手等场景。通过模拟搜索引擎,模型能够提供更准确、更可靠的答案。

(二)内容创作

ZeroSearch 能够帮助创作者获取信息,生成初稿或提供灵感,适用于新闻、文案和学术写作等领域。通过动态控制文档质量,模型可以为创作者提供多样化的信息支持。

(三)教育与学习

ZeroSearch 可以为学生提供即时解答,支持在线教育和智能辅导。通过模拟搜索引擎,模型能够提供更准确、更可靠的知识支持。

(四)企业知识管理

ZeroSearch 能够帮助员工快速检索公司内部资源,提高工作效率。通过动态控制文档质量,模型可以为企业提供多样化的知识管理支持。

(五)研究与开发

ZeroSearch 能够为研究人员提供最新研究成果,加速研究进程。通过模拟搜索引擎,模型能够提供更准确、更可靠的研究支持。

五、快速使用

(一)安装依赖

首先,确保您的系统中安装了必要的依赖项。以下是安装步骤:

conda create -n zerosearch python=3.9 # 创建一个新的 Conda 环境conda activate zerosearch # 激活环境pip install torch==2.4.0 --index-url https://download.pytorch.org/whl/cu121 # 安装 PyTorchpip install vllm==0.6.3 # 安装 vllmpip install wandb # 安装 Weights & Biases,用于实验跟踪pip install serpapi # 安装 SerpAPI,用于与真实搜索引擎交互(可选)

(二)下载训练数据集

接下来,下载ZeroSearch 的训练数据集。这些数据集用于训练和微调模型:

huggingface-cli download --repo-type dataset --resume-download sunhaonlp/ZeroSearch_dataset --local-dir ZeroSearch_dataset此命令会从Hugging Face 数据集仓库中下载 ZeroSearch 数据集,并保存到本地的 `ZeroSearch_dataset` 文件夹中。

(三)下载模拟LLM

ZeroSearch 使用预训练的模拟 LLM 来生成文档。您可以根据需要选择不同参数规模的模型:

huggingface-cli download --resume-download sunhaonlp/SearchSimulation_3B --local-dir SearchSimulation_3Bhuggingface-cli download --resume-download sunhaonlp/SearchSimulation_7B --local-dir SearchSimulation_7Bhuggingface-cli download --resume-download sunhaonlp/SearchSimulation_14B --local-dir SearchSimulation_14B

这些命令会从Hugging Face 模型仓库中下载不同参数规模的模拟 LLM,并保存到本地的 `SearchSimulation_3B`、`SearchSimulation_7B` 和 `SearchSimulation_14B` 文件夹中。

(四)启动本地模拟服务器

启动本地模拟服务器,以便在训练过程中使用模拟LLM:

python -m sglang.launch_server --model-path SearchSimulation_3B --host 0.0.0.0 --tp 2 --dp 2 --port 6001此命令会启动一个本地服务器,监听端口`6001`,并使用 `SearchSimulation_3B` 模型作为模拟搜索引擎。您可以根据需要更改模型路径和端口。

(五)进行强化学习训练

最后,使用ZeroSearch 提供的脚本进行强化学习训练。以下是使用 GRPO 算法的示例:

bash train_grpo.sh NUM_GPUS_PER_NODE 4 MODEL_PATH Llama-3.2-3B DATA_PATH ZeroSearch_dataset TOTAL_STEPS 203 IP localhost SEARCH_MODE simulate_sft SIMULATION_LLM SearchSimulation_3B START_THRESHOLD 0.25 END_THRESHOLD 0.5此脚本会启动训练过程,使用4 个 GPU,`Llama-3.2-3B` 作为策略模型,`ZeroSearch_dataset` 作为训练数据集,总共训练 203 步。`SEARCH_MODE` 设置为 `simulate_sft`,表示使用轻量级监督微调的模拟搜索引擎,`SIMULATION_LLM` 设置为 `SearchSimulation_3B`,表示使用 3B 参数规模的模拟 LLM。`START_THRESHOLD` 和 `END_THRESHOLD` 分别设置为 0.25 和 0.5,用于控制课程学习机制的难度。

六、结语

ZeroSearch 作为阿里巴巴通义实验室开源的创新大模型搜索引擎框架,通过模拟搜索引擎的方式激励大模型的搜索能力,无需与真实搜索引擎交互,大幅降低了训练成本,同时提升了模型的推理能力。它在多个问答数据集上的性能超过谷歌搜索,具有很强的扩展性和通用性。ZeroSearch 的开源为自然语言处理领域带来了新的可能性,为研究者和开发者提供了一个高效、灵活的工具。

七、相关资源

项目官网:https://alibaba-nlp.github.io/ZeroSearch/

GitHub 仓库:https://github.com/Alibaba-nlp/ZeroSearch

HuggingFace 模型库:https://huggingface.co/collections/sunhaonlp/zerosearch

技术论文:https://arxiv.org/pdf/2505.04588

(文:小兵的AI视界)