聊聊 AI 领域的一个新动向。虽然现在的大模型很强大,但在灵活性、效率,尤其是像人一样举一反三、理解世界方面,还是差了很多

来自东京的 Sakana AI (Transformer 作者之一Llion Jones联合创立)认为,关键可能在于我们简化 AI 模型时,丢掉了一个生物大脑的核心要素——时间

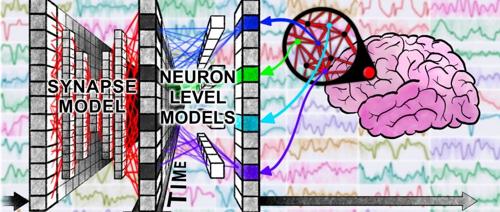

基于此Sakana AI 正式推出了他们研发的新型 AI 模型——持续思考机器(Continuous Thought Machine, CTM)。这个 CTM 的核心理念,就是重新将「时间」和「神经元动态」引入 AI 计算的核心

blog:

https://sakana.ai/ctm/

https://pub.sakana.ai/ctm/

paper:

https://arxiv.org/abs/2505.05522

code:

https://github.com/SakanaAI/continuous-thought-machines/

CTM 的创新之处

传统的神经网络(ANNs),比如我们熟悉的 CNN、Transformer,虽然也受大脑启发,但为了计算效率,往往将神经元的复杂动态过程简化为一个静态的激活值。神经元什么时候、以何种节奏、与其他神经元如何协同放电——这些丰富的时序信息,基本被忽略了

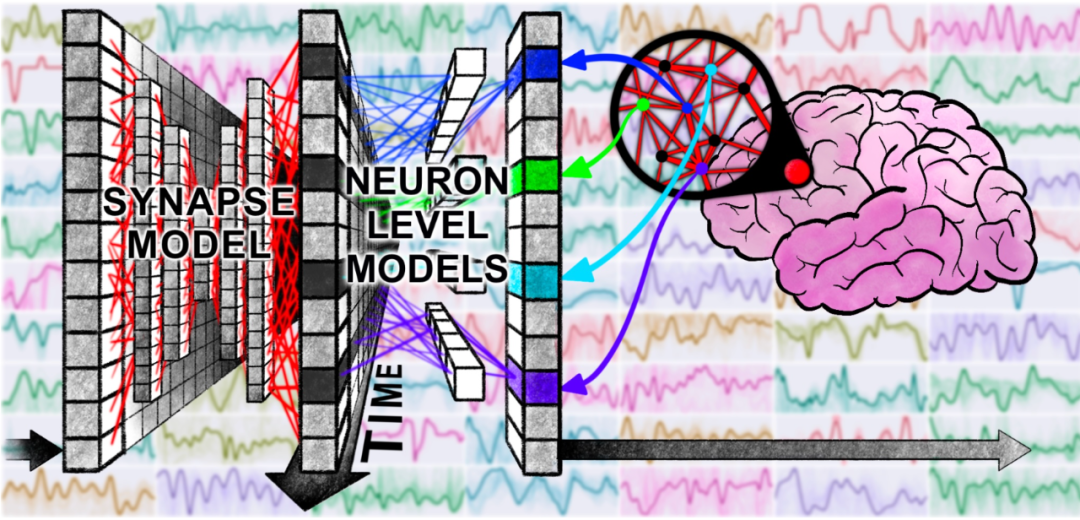

Sakana AI 的 CTM 试图改变这一点,它有几个关键的创新:

1.引入「内部思考维度」 (Internal ‘Thinking’ Dimension): CTM 可以在一个独立于外部数据输入节奏的内部时间维度上运行。想象一下,无论给它看一张静态图片,还是一个需要逐步解决的迷宫,CTM 都能在内部进行多步的“思考”和推理,迭代地构建和优化它的理解。这有点像我们人类在解决问题前,会先在脑子里“琢磨”一下

2.神经元级别的时序处理 (Neuron-Level Models, NLMs): CTM 里每个神经元不再是简单的激活函数(如 ReLU)。相反,每个神经元都有自己独立的、带参数的模型(比如一个小型 MLP),它会处理一小段历史的输入信号(pre-activations),来计算当前的输出(post-activation)。这意味着每个神经元都能根据近期的动态输入调整自己的行为,从而产生极其丰富和复杂的神经活动模式

3.神经同步作为核心表征 (Neural Synchronization as Representation): 这是 CTM 最具颠覆性的一点。它不再仅仅依赖神经元的激活值向量作为信息载体。CTM 会追踪神经元在内部思考过程中的放电历史,计算不同神经元之间活动的同步程度(形成一个“同步矩阵”)。这个“同步信息”被直接用作模型的潜在表征 (latent representation),驱动模型进行注意力分配(看哪里)和最终的预测输出(是什么/怎么做)。换句话说,神经元之间如何协同“起舞”,这个动态模式本身,就是 CTM 用来理解世界和做出决策的核心依据

CTM 测试

由于新增了时间维度,CTM 的一大优势在于,可以观察并直观地看到它如何随着时间的推移解决问题。与传统的 AI 系统不同,传统的 AI 系统可能只需通过神经网络一次即可对图像进行分类,而 CTM 可以分多个步骤来“思考”如何解决任务

为了展示 CTM 的强大功能和可解释性,Sakana AI 在下面展示了两个任务:迷宫探索和照片中的物体分类

像人一样破解迷宫: 在这个任务中,CTM 会被呈现一个二维自上而下的迷宫,并被要求输出解决迷宫所需的步骤。这种模式尤其具有挑战性,因为模型必须理解迷宫结构并规划解决方案,而不是简单地输出路径的视觉表示。CTM 内部连续的“思考步骤”使其能够制定计划,我们可以直观地看到它在每个思考步骤中关注迷宫的哪些部分。值得注意的是,CTM 学会了一种非常类似于人类的迷宫求解方法——我们可以在它的注意力模式中看到它沿着迷宫路径前进。

Sakana AI 还为此制作了交互式 Demo,你可以在浏览器里亲自“指挥”或观看 CTM 解迷宫!

CTM 通过观察(使用注意力机制)并直接生成步骤(例如,向左、向右等)来解决迷宫问题。它直接利用神经动力学的同步(即使用基于同步本身的线性探测)来实现这一点

实验结果显示,CTM 不仅仅能高效解决 39×39 的迷宫,远超 LSTM 等基线模型,甚至在面对从未见过的、路径更长、尺寸更大(如 99×99)的迷宫时,也能展现出惊人的泛化能力

更「懂」图像识别: 在 ImageNet 和 CIFAR 图像分类任务上,CTM 虽然目前精度还没刷到 SOTA(研究团队也表示目标并非刷榜),但展现了独特的优势:

-

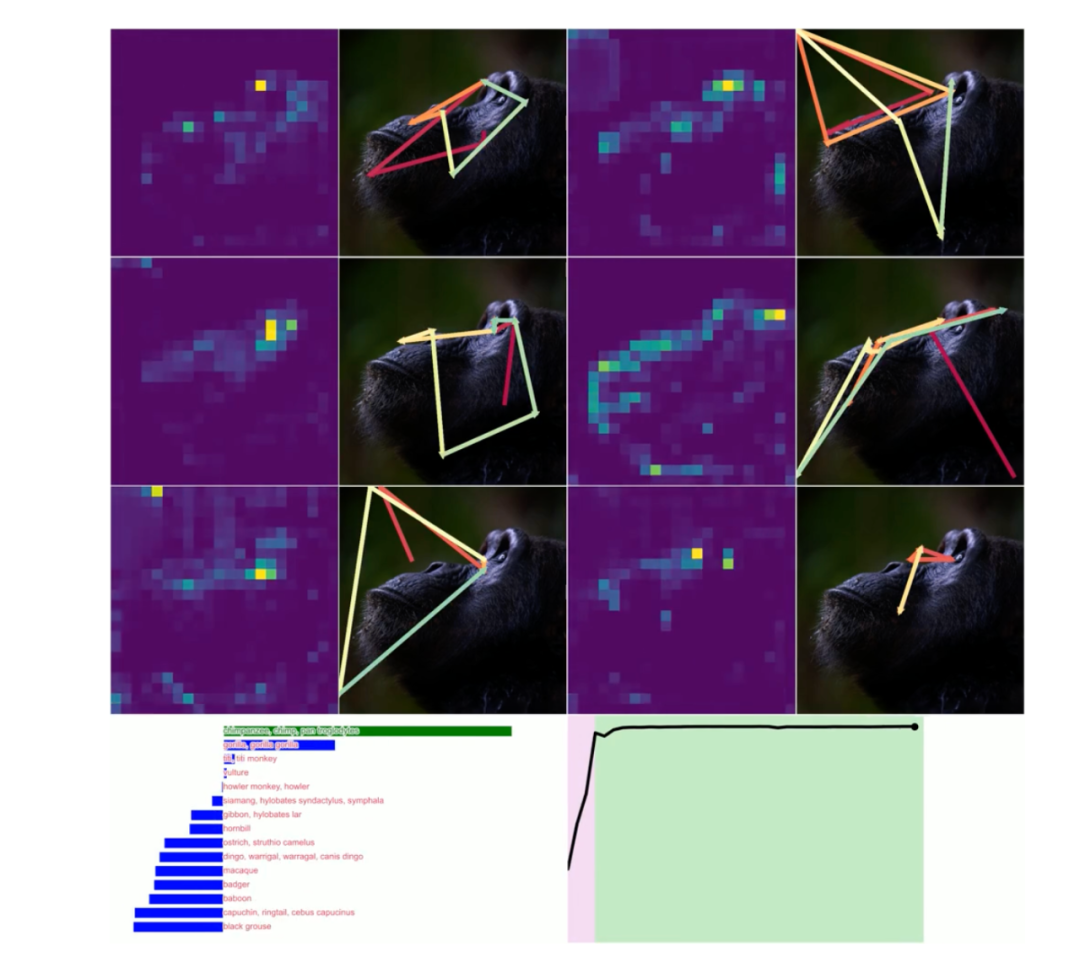

• a.可解释性强: 注意力机制的可视化显示,CTM 在识别图像时,其“注视点”会像人眼一样在不同显著区域(如动物的眼睛、鼻子、嘴巴)之间平滑移动,例如,在识别大猩猩时,CTM 的注意力会从眼睛转移到鼻子,再转移到嘴巴,这与人类的视觉注意力模式非常相似 -

-

• b.优秀的校准度 (Calibration): CTM 对自己预测的置信度非常“诚实”,甚至比人类标注者的平均水平还要准。这意味着当它说“我很确定”时,你大概率可以相信它 -

-

• c.自适应计算: 对于简单的图像,CTM 会“觉得”差不多了,用较少的内部思考步骤就给出高置信度答案;而对于复杂的图像,它会自然地进行更多步的思考。这种能力是其架构和特殊损失函数(结合最低损失点和最高置信度点的预测)带来的涌现特性,无需额外复杂设计 -

-

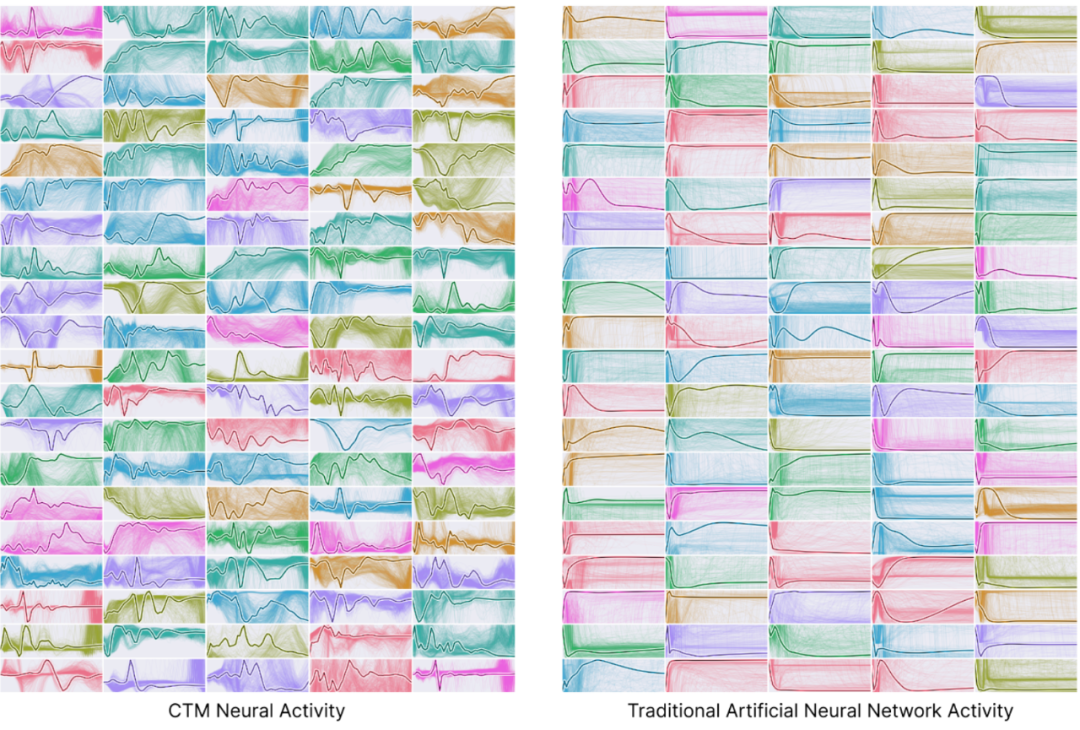

• d.丰富的神经动态: 对比 CTM 和 LSTM 在处理图像时的神经元活动,你会发现 CTM 的神经元活动模式更加多样和复杂,呈现出类似生物神经信号的多尺度、甚至周期性振荡的行为(尽管没有外部驱动信号),这与 LSTM 相对单调的动态形成鲜明对比。研究者甚至观察到了类似大脑皮层中“行波 (traveling waves)”的现象

算法推理与记忆: 在排序、奇偶校验 (Parity)、Q&A MNIST(看图回答计算题)等任务中,CTM 也表现出色。尤其是在 Q&A MNIST 任务里,即使需要回忆的数字已经超出了神经元模型的直接“记忆窗口”(输入的历史长度 M),CTM 依然能通过神经同步机制成功提取信息并进行计算,证明了同步表征在记忆和信息检索方面的潜力

持续交互: 在强化学习(CartPole, Acrobot, MiniGrid)任务中,CTM 也能在与环境的持续互动中学习策略,展现出与 LSTM 基线相当的性能,但其神经动态依然更加丰富

AI 向生物智能迈出的重要一步?

CTM 的出现,至少给我们带来了几点思考:

弥合差距: 它在 AI 的计算效率与生物智能的动态复杂性之间,架起了一座有趣的桥梁

表征: “神经同步”作为一种全新的信息表征方式,其潜力和应用场景值得深入探索,尤其是在需要整合长期依赖、进行复杂推理和记忆的任务中。同步矩阵本身提供了一个巨大的、无需额外参数成本的高维表征空间

涌现与可解释性: CTM 的许多能力(如自适应计算、路径追踪)是自然涌现的,而非刻意设计,并且其思考过程相对透明,这对于构建更值得信赖的 AI 系统至关重要。

未来方向: Sakana AI 提到,未来会将 CTM 应用于语言模型、视频等时序数据,探索在更自然的“连续世界”设定下进行训练,甚至结合生物可塑性原理(如 Hebbian 学习)进行梯度无关的优化

当然,CTM 并非完美:

训练速度: 其内部的串行思考过程无法像传统模型那样大规模并行,训练时间会更长

参数开销: 每个神经元都有自己的模型(NLMs),这会带来额外的参数量。

写在最后

尽管现代人工智能以大脑为基础,形成“人工神经网络”,但即使在今天,人工智能研究与神经科学之间的重叠仍然少得惊人。人工智能研究人员选择沿用上世纪80年代开发的极其简单的模型,因为它简单易用、训练高效,并且在推动人工智能发展方面持续取得成功。另一方面,神经科学将创建更精确的大脑模型,但其主要目的是理解大脑,而不是试图创建更高级的智能模型(当然,两者之间也可能存在某种关联)。尽管这些神经科学模型更加复杂,但它们的表现通常仍不及我们目前最先进的人工智能模型,因此,它们或许在人工智能应用方面缺乏进一步研究的吸引力

如果现代人工智能在某些方面不继续向大脑靠拢,就错失了良机,我们或许可以通过这种方式找到更强大、更高效的模型。2012 年,人工智能能力的大幅提升,即所谓的“深度学习革命”,正是源于神经网络——一个受大脑启发的模型。为了延续这一进步,我们是否应该继续受到大脑的启发?CTM 是首次尝试弥合这两个领域之间的差距,它展现出一些更接近大脑行为的初步迹象,同时仍然是一个解决重要问题的实用人工智能模型

感兴趣的朋友,强烈建议去 Sakana AI 的项目主页体验交互式 Demo,并深入阅读他们的技术报告原文和开源代码,链接如下:

项目主页 & 交互 Demo:

https://sakana.ai/ctm/ 或 https://pub.sakana.ai/ctm/

技术报告 (PDF):

[arXiv:2505.05522v1]

开源代码 (GitHub):

https://github.com/SakanaAI/continuous-thought-machines/

关于 Sakana AI 这家公司

Sakana AI 是一家专注于人工智能基础模型研究的公司,总部位于日本东京

创始团队: 这家公司由两位 AI 领域的重量级人物于 2023 年创立:

-

• David Ha: 他之前在 Google Brain 和 Stability AI 工作,以其在 World Models、生成模型、神经进化以及探索 AI 创造力方面的工作而闻名 -

• Llion Jones: 他是著名的 “Attention Is All You Need” 论文的共同作者之一,这篇论文引入了 Transformer 架构,是当今绝大多数大型语言模型(LLMs)的基础。Llion Jones 之前也在 Google 工作

研究方向与理念: Sakana AI 的一个显著特点是其研究理念——从自然界和生物系统中汲取灵感来构建新一代的 AI

公司名字 “Sakana” 在日语中意为“鱼”,这象征着他们希望从鱼群等自然界的集体智能 (Collective Intelligence)和进化 (Evolution)过程中获得启发

他们探索的方向不仅仅是简单地扩大现有模型的规模,而是寻求新的架构和学习范式。例如,他们研究如何:

-

• 使用进化算法来自动发现合并或组合现有开源模型的方法,以创造新的能力。 -

• 探索来自人工生命 (Artificial Life) 的概念 -

• 开发受生物学启发的模型,比如你刚了解到的持续思考机器 (CTM),它就明确地借鉴了大脑中神经元的时间动态和同步机制

⭐

(文:AI寒武纪)