Transformer模型

继AlphaFold之后,DeepMind再放“大招”:AlphaGenome直击疾病根源

谷歌DeepMind推出AlphaGenome AI模型,用于更深入、准确预测基因变异,加速疾病研究、基因治疗及基础生命科学。

OpenAI底层AGI技术被曝光!前研究主管豪言:从此再无新范式

OpenAI前研究主管Bob McGrew指出,预训练、推理和多模态能力是实现AGI的关键,而2025年将是推理之年。他强调预训练仍然重要但收益递减,而推理则面临技术潜力逐渐被「消耗殆尽」的挑战。

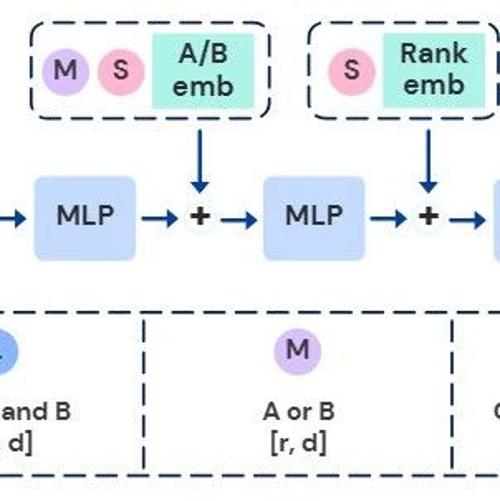

ICML’25 告别手动SFT!一句话得到你的专属大模型LoRA

Text-to-LoRA 框架通过自然语言指令动态生成适当的 LoRA 适配器,实现 Transformer 模型的即时、动态适配,显著减少工程开销和部署时间。

罕见合著!谷歌、Meta、英伟达团队联手发文,揭秘语言模型 “记忆” 能力

一篇新论文揭示了语言模型的记忆能力,并提出了新的量化指标用于衡量这种能力。研究表明,Transformer模型每个参数大约可存储3.5到4比特信息,模型的“记忆”与其泛化能力有关,理解这一点有助于开发更安全、可靠的大规模AI系统。

ICML 2025 长文本救星!清华等提出傅里叶位置编码,多项任务全面超越RoPE

清华大学团队研究发现,RoPE 带来的周期性延拓受到频谱损坏影响限制了 LM 的长度外推能力。他们提出傅里叶位置编码(FoPE)来提升 Transformer 的长文本泛化能力。