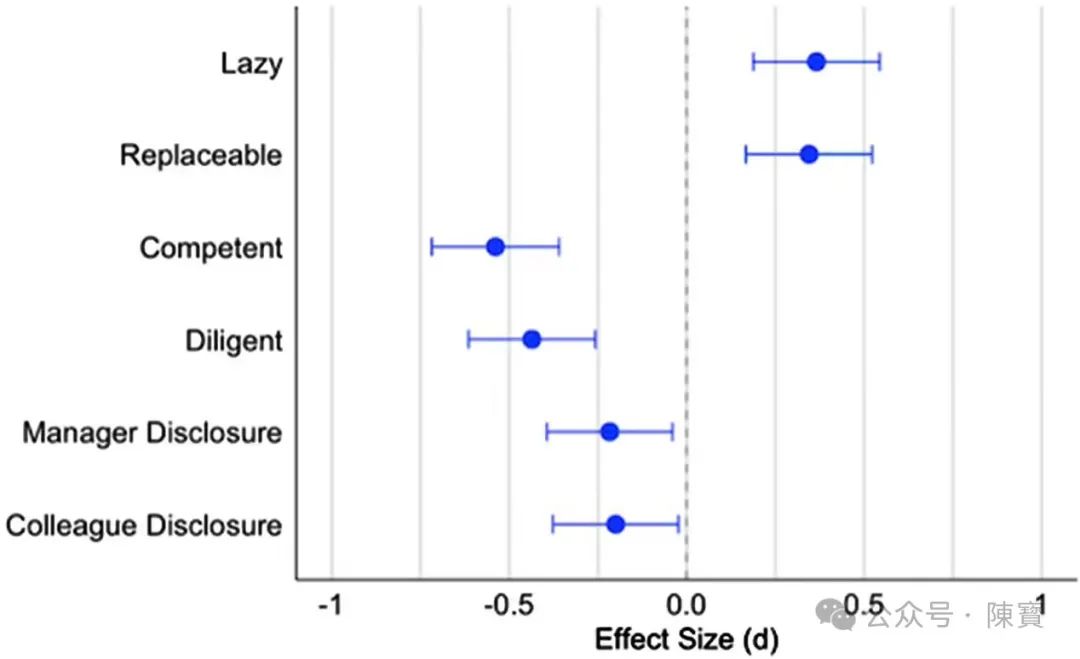

当今职场,生成式AI已成为许多专业人士的得力助手,从撰写报告到数据分析,AI工具大幅提升了工作效率。然而,美国杜克大学在《美国国家科学院院刊》(PNAS)上发表的一项研究,揭示了一个令人深思的现象:即使AI助手所产出的工作成果质量上乘,从业者仍可能被贴上诸如能力不足、懒惰等负面标签。

该研究涉及4439名参与者,结果显示任务难度或耗时程度越高,使用AI所引发的负面评价就越显著。个人觉得它不仅暴露了技术工具与社会认知之间的深层次矛盾,也反映出数字时代职场评价体系的系统性失灵。

⋯ ⋯

职场评价体系的认知惯性,导致对努力过程的重视早已深植于文明的基因之中。

在石器时代,花费三天时间精心打磨箭头的工匠,相较于那些借助他人工具的人,无疑会受到更多的尊敬;而在工业革命初期,蒸汽机操作员因缺乏手工技艺而遭到传统工匠的鄙视。

杜克大学的研究揭示了相同的认知逻辑,当AI承担了诸如信息检索、数据分析等显性劳动时,旁观者往往会因努力可视性缺失而形成价值误判。

知识经济时代,认知偏差的存在尤为危险。研究表明,评估者对脑力劳动过程的判断往往依赖于主观想象,而AI的介入恰好模糊了这种想象的空间。

例如,律师借助AI完成法律条文检索时,其专业洞察力被算法所掩盖,导致客户误认为律师只是机器指令的搬运工,该现象本质上是前数字时代评价标准对新型生产力的滞后反应。

⋯ ⋯

AI引发的专业质疑,实际上是社会对技术失控焦虑的一种转嫁。

DeepSeek将工作效率提升300%时,职场人本能地通过贬低使用者来维持人优于机器的心理平衡。

类似于19世纪纺织工人砸毁珍妮机的行为,并非否定机器的效率,而是出于对自身价值消解的恐惧。

研究中的招聘模拟实验极具启示意义,不常用AI的管理者更倾向于拒绝AI使用者,而高频使用者则愿意接纳同类。

分裂现象印证了工具认知的镜像理论,人们将自己的技术态度投射到他人身上,从而形成道德评判。在AI普及率不足的时候,使用者被迫承担技术伦理争议的人形载体。

⋯ ⋯

想要突破污名化的关键,在于重构能力评价的维度才行。

斯坦福大学2024年的研究指出,优秀AI协作者的核心竞争力已从直接产出能力转向提示词工程、结果校准、伦理审查三大新维度。

提示词设计能力中,如通过精准指令让ChatGPT生成合规法律文件,应被视为专业素养的延伸。

算法纠偏能力上,识别AI输出中的逻辑漏洞,应该成为质量控制的新标准。

人机协作透明度中,明确标注AI贡献比例,能够转化为职业道德优势。

⋯ ⋯

组织进化过程中,管理范式也会进行适应性变革,我认为企业需要建立AI时代的能力评估体系。

(一)任务分级制度,将工作拆解为基础层和决策层,分别制定评价标准。

(二)过程可视化工具,开发能够记录AI操作日志的协作平台,使思维过程可追溯。

(三)反偏见培训,通过认知实验展示AI使用者的决策树复杂度,打破一键生成的刻板印象。

微软的Viva平台已试行AI贡献度仪表盘,将提示词迭代次数、结果修正维度等转化为能力评估指标。数据显示,该措施使AI使用者的能力认可度提升了47%。

⋯ ⋯

未来时间里面,认知能力是否能跟得上是很关键的能力。当AI工具像Excel一样普及之时,负面标签或许将逆转。

历史的规律总是惊人的相似,曾经被视作作弊的计算器,如今已成为财务能力的必备要素。杜克研究的真正启示在于,当前正处于工具认知转型期,个体的策略选择将决定长期职业轨迹。

唯一不变的是,变化正在不断地发生着。这就需要主动构建人机协同的证据链能力了,在提升效率的同时塑造智能增强型专家形象,才是破局的关键。

AI引发的专业形象危机,本质上是工具理性与价值理性的短暂失衡。正如杜克研究者所指出的,当AI应用于日常工作难以企及的领域时,负面评价会显著降低。

职场价值的终极锚点,始终在于独有的批判性思维与价值判断。正如苏格拉底担忧文字会摧毁记忆时的历史轮回,普通人终将在与技术的共舞中,找到认知评价的新平衡。

(文:陳寳)